Cherry Studio+Filesystem MCP Server:搭建个人智能文件助手

然而,由于科学上网的原因,国内用户不方便使用 Claude Desktop。本文介绍一款桌面 AI 客户端 Cherry Studio。Cherry Studio 是面向国内用户的 AI 桌面客户端,不仅具有 Claude Desktop 的文件交互能力,还提供多模型调度、编程助手与知识管理等进阶功能。本文主要内容:Cherry Studio 的功能特性与安装使用Filesystem MCP Se

MCP 的官方文档的 QuickStart,介绍了基于 Claude Desktop 和 Filesystem MCP Server,实现了对本地文件的智能操作:用户以自然语言的形式下指令,大模型识别用户意图,并通过 MCP 服务端对本地文件系统的文件进行读取、搜索、创建等操作。

然而,由于科学上网的原因,国内用户不方便使用 Claude Desktop。本文介绍一款桌面 AI 客户端 Cherry Studio。Cherry Studio 是面向国内用户的 AI 桌面客户端,不仅具有 Claude Desktop 的文件交互能力,还提供多模型调度、编程助手与知识管理等进阶功能。 本文主要内容:

-

Cherry Studio 的功能特性与安装使用

-

Filesystem MCP Server 介绍

-

基于 Cherry Studio+Filesystem MCP Server,搭建个人智能文件助手

Cherry Studio

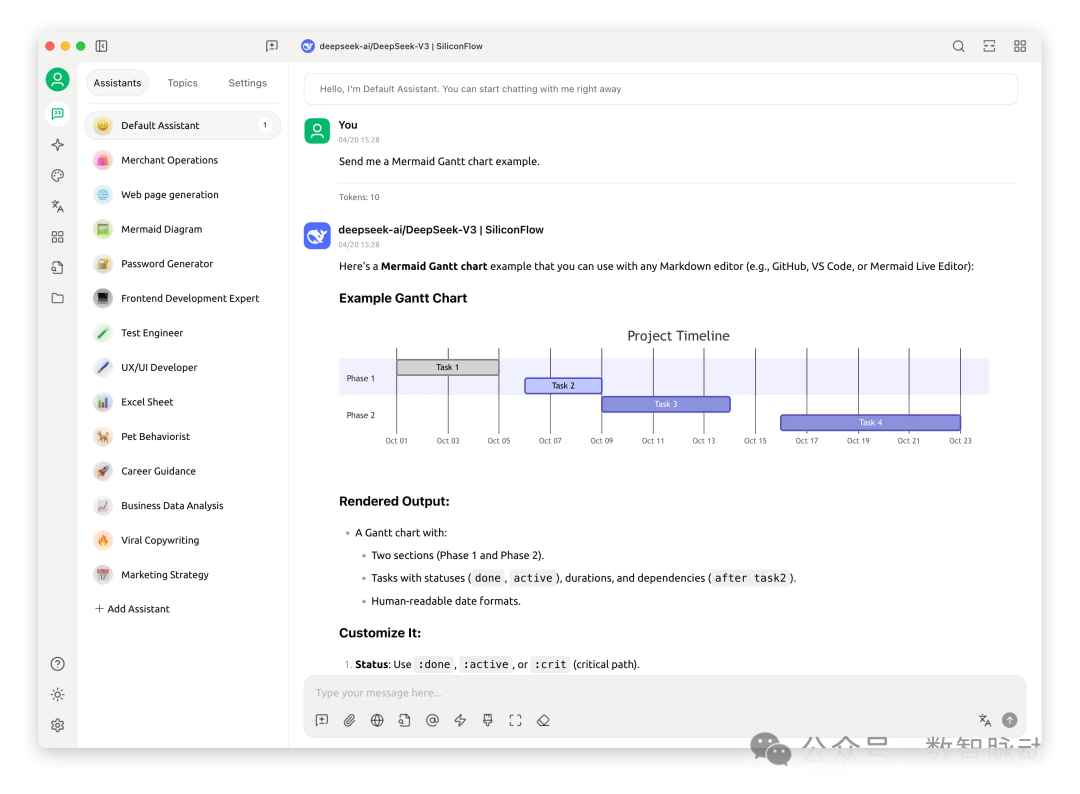

Cherry Studio 是一款集多模型对话、知识库管理、AI 绘画、翻译等功能于一体的全能 AI 助手平台。 Cherry Studio 高度自定义的设计、强大的扩展能力和友好的用户体验,使其成为专业用户和 AI 爱好者的理想选择。无论是零基础用户还是开发者,都能在 Cherry Studio 中找到适合自己的 AI 功能,提升工作效率和创造力。

官方网站:https://www.cherry-ai.com/

官方文档:https://docs.cherry-ai.com/

github 项目地址:https://github.com/CherryHQ/cherry-studio,目前已有 29.4 K stars

Cherry Studio 的三大特性:

-

💬全能 AI 助手:支持多服务商集成的 AI 对话客户端。

-

📚个性化知识库:支持多种格式文件导入和网页导入等方式来搭建个性化知识库。

-

🔒保障隐私安全:所有使用数据都储存在本地,不会上传到任何第三方服务器,并且支持本地部署的模型调用。

🧠 核心功能

1、多样化模型支持

-

☁️ 主流云服务:OpenAI、Gemini、Anthropic 等大语言模型云服务

-

🔗 AI网页集成:Claude、Perplexity、Poe、腾讯元宝等网页端AI服务

-

💻 本地模型支持:通过 Ollama、LM Studio 部署本地私有模型

2、AI助手与对话系统

-

📚 300+预设助手:覆盖编程、写作、翻译等专业领域

-

🤖 自定义助手:支持创建个性化AI角色

-

💬 多模型并行对话:同时向多个AI提问并对比回答

3、文档与数据处理

-

📄 多格式支持:文本、图片、Office文档、PDF等

-

☁️ WebDAV文件管理:云端备份与跨设备同步

-

📊 Mermaid图表:流程图/时序图可视化

-

💻 代码高亮:支持主流编程语言语法

4、实用工具集成

-

🔍 全局搜索:快速检索历史对话与文档

-

📝 主题管理:按项目分类对话记录

-

🔤 AI翻译:多语言实时互译

-

🎯 拖拽排序:界面元素自由调整

-

🔌 小程序支持:扩展第三方功能

-

⚙️ MCP服务器:支持模型上下文协议(文件/数据库安全交互)

5、用户体验优化

-

🖥️ 跨平台支持:Windows、macOS、Linux

-

📦 开箱即用:无需配置环境,安装即启动

-

🎨 主题与窗口:明/暗主题切换+透明窗口效果

-

📝 Markdown渲染:完整支持Markdown语法

-

🤲 内容分享:一键导出对话与图表

🚀 功能规划

后续 Cherry Studio 将推出以下功能:

|

类别 |

功能亮点 |

|---|---|

|

🎯 核心增强 |

智能内容选择优化 · 深度研究能力 · 全局记忆系统 · 文档预处理升级 · MCP生态市场 |

|

🗂 知识管理 |

笔记与收藏集 · 动态画布可视化 · OCR文字识别 · TTS语音合成 |

|

📱 平台扩展 |

HarmonyOS版 · Android/iOS应用(第一阶段) · 多窗口支持 · 窗口置顶功能 |

|

🔌 高阶特性 |

插件系统 · 语音识别(ASR) · 助手与主题交互重构 |

安装与使用

在下载页面:https://docs.cherry-ai.com/cherry-studio/download,选择与操作系统匹配的版本下载后,点击 exe 文件,按照提示指引,完成安装。

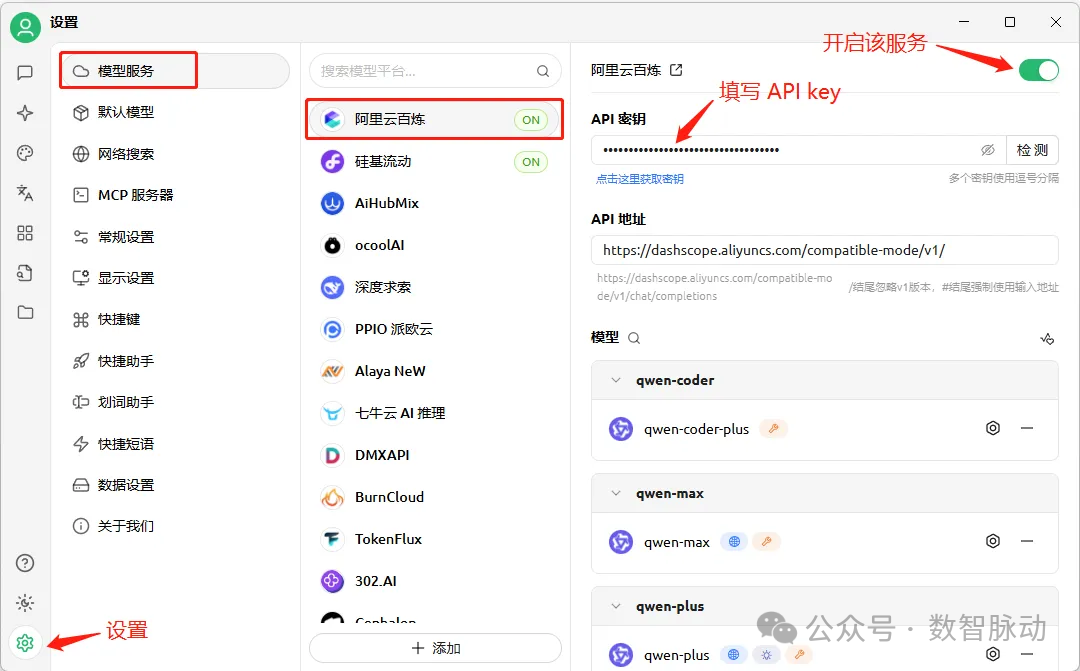

模型服务配置

设置模型服务,以选择阿里云的模型服务为例:点击左下角的设置按钮,选择模型服务,选择模型供应商:阿里云百炼;填写 API key;点击右上角的按钮,开启该服务。

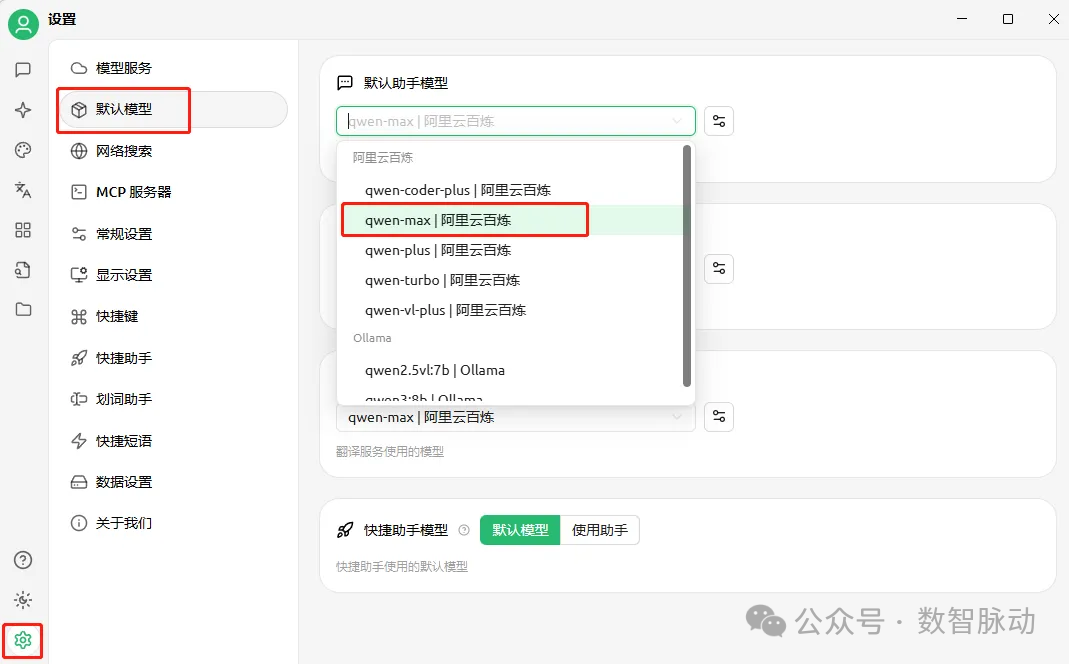

设置默认模型:点击默认模型,选择阿里云百炼的 qwen-max 模型作为默认助手模型。

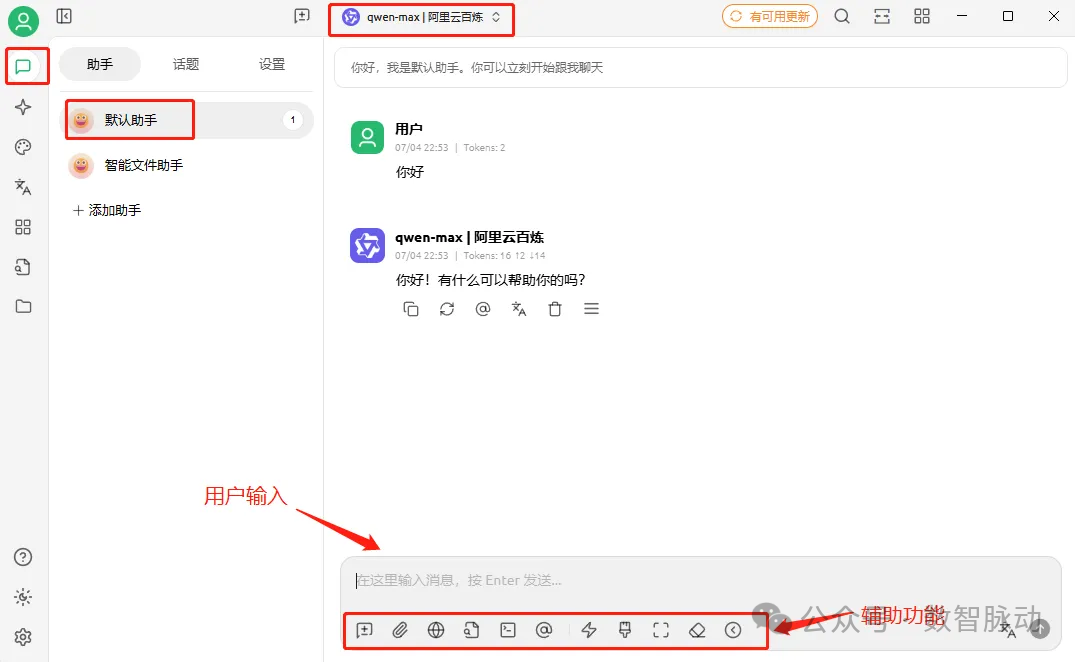

与模型对话:点击左上角的对话按钮,选择默认助手,开启与大模型的对话(默认模型是之前设置的 qwen-max)。下方可选择辅助功能,如选择模型、网络搜索、MCP 服务器等。

Cherry Studio 具有丰富的功能,具体使用说明,可阅读官方文档:https://docs.cherry-ai.com/

Filesystem MCP Server

Filesystem MCP Server 是 MCP 官方仓库的一个 MCP 服务端实现。它将文件系统操作(如读文件、写文件、管理目录)暴露为 MCP 协议定义的标准接口(Tools)。这使得遵守 MCP 协议的 AI 模型能够安全地与主机文件系统进行交互。

项目地址:https://github.com/modelcontextprotocol/servers/tree/main/src/filesystem

主要功能

-

read_file: 读取单个文件的完整内容 (UTF-8)。

-

read_multiple_files: 同时读取多个文件的内容(错误文件不影响其他读取)。

-

write_file: 创建新文件或覆盖现有文件内容(使用时需谨慎)。

-

edit_file (高级功能): 对文件内容进行选择性编辑。

-

create_directory: 创建目录(包括父目录),如果目录已存在则静默成功。

-

list_directory: 列出目录内容,并用 [FILE] 或 [DIR] 标记类型。

-

move_file: 移动或重命名文件和目录。

-

search_files: 递归搜索匹配特定模式(支持 glob,不区分大小写)的文件/目录,并可排除特定模式。

-

get_file_info: 获取文件/目录的详细元数据(大小、创建/修改/访问时间、类型、权限)。

-

list_allowed_directories: 列出服务器被允许访问的所有目录。

技术实现与部署

语言: Node.js

部署方式:

1、Docker (推荐且安全):

-

构建镜像:docker build -t mcp/filesystem -f src/filesystem/Dockerfile .

-

运行容器:通过 docker run 命令启动,使用 --mount 参数将宿主机上允许访问的目录绑定挂载 (bind mount) 到容器内的 /projects 路径下。可以设置 ro 标志控制只读访问。

-

Docker 部署天然提供了一层隔离。

服务配置示例:

{

"mcpServers": {

"filesystem": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"--mount", "type=bind,src=/Users/username/Desktop,dst=/projects/Desktop",

"--mount", "type=bind,src=/path/to/other/allowed/dir,dst=/projects/other/allowed/dir,ro",

"--mount", "type=bind,src=/path/to/file.txt,dst=/projects/path/to/file.txt",

"mcp/filesystem",

"/projects"

]

}

}

}

2、NPX (便捷,但隔离性弱于 Docker):

使用 npx 直接运行包 (@modelcontextprotocol/server-filesystem),在命令后跟上允许访问的本地目录路径列表。 配置示例:

{

"mcpServers": {

"filesystem": {

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-filesystem",

"/Users/username/Desktop",

"/path/to/other/allowed/dir"

]

}

}

}

使用该运行方式,需要在本机安装 node.js 。可在 https://nodejs.org/zh-cn 上下载安装包进行安装。安装完成后,在终端输入:node --version,验证是否已安装成功。

C:\Users\yuan_>node --version

v22.17.0

搭建个人智能文件助手

配置 MCP 服务端

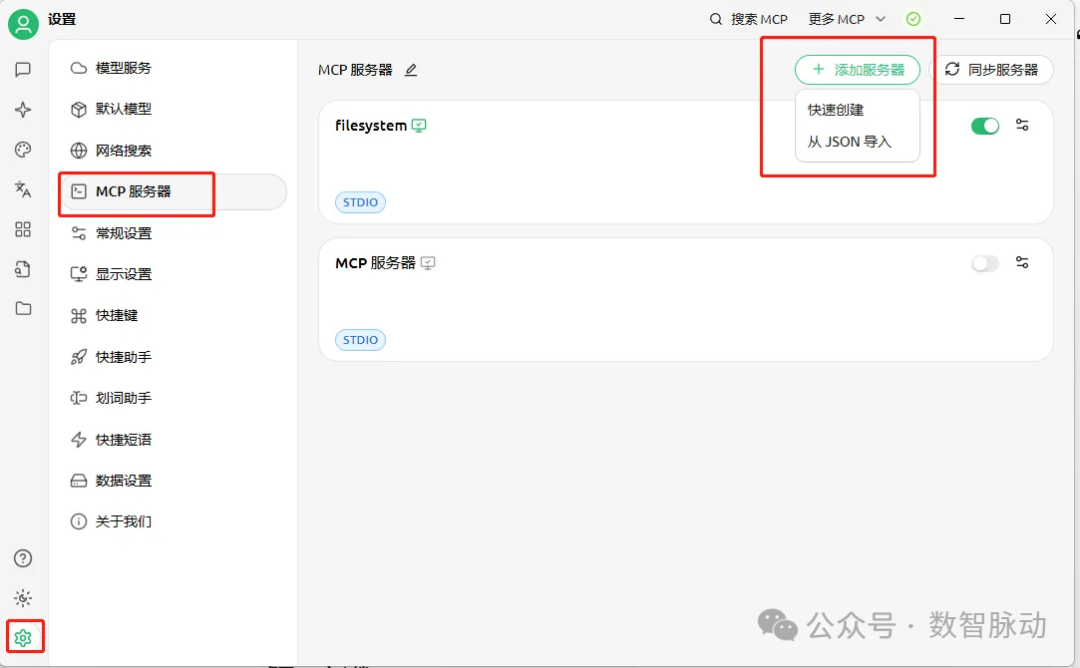

点击 Cherry Studio 的设置,选择 MCP 服务器,点击右上角的“添加服务器”,可以选择可视化的快速创建、从 JSON 导入两种方式:

以 JSON 方式,配置 Filesystem MCP Server,允许访问我的桌面和下载目录。

{

"mcpServers": {

"filesystem": {

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-filesystem",

"C:\\Users\\yuan_\\Desktop",

"C:\\Users\\yuan_\\Downloads"

]

}

}

}

保存 JSON,即创建 MCP 服务器。

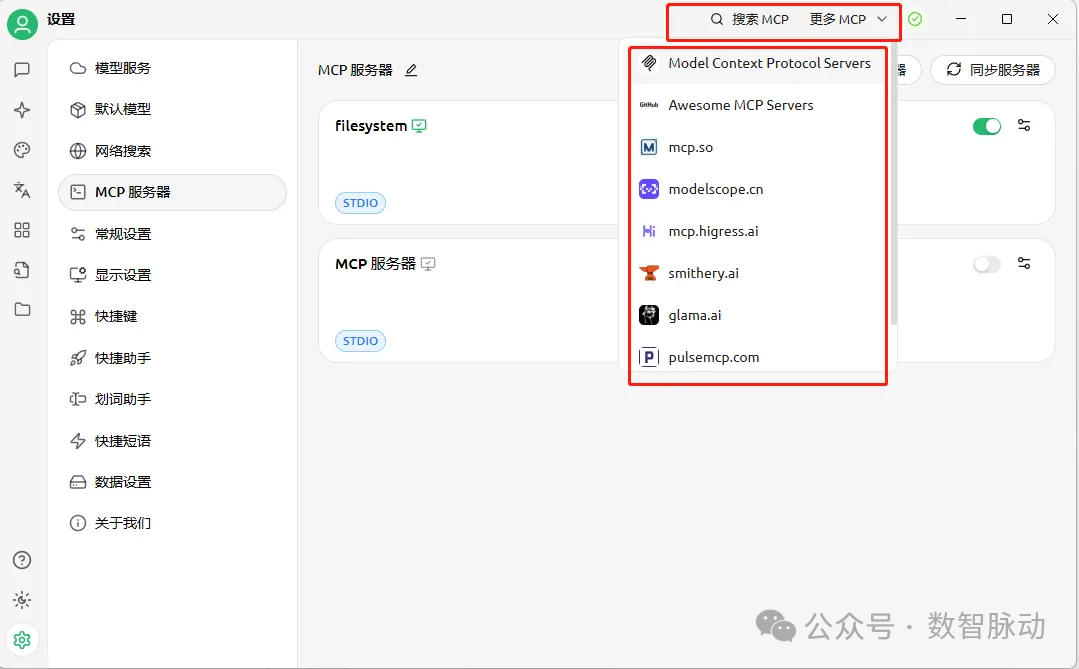

我们还可以点击上方的搜索 MCP 服务器,发现更多第三方已实现的 MCP 服务器:

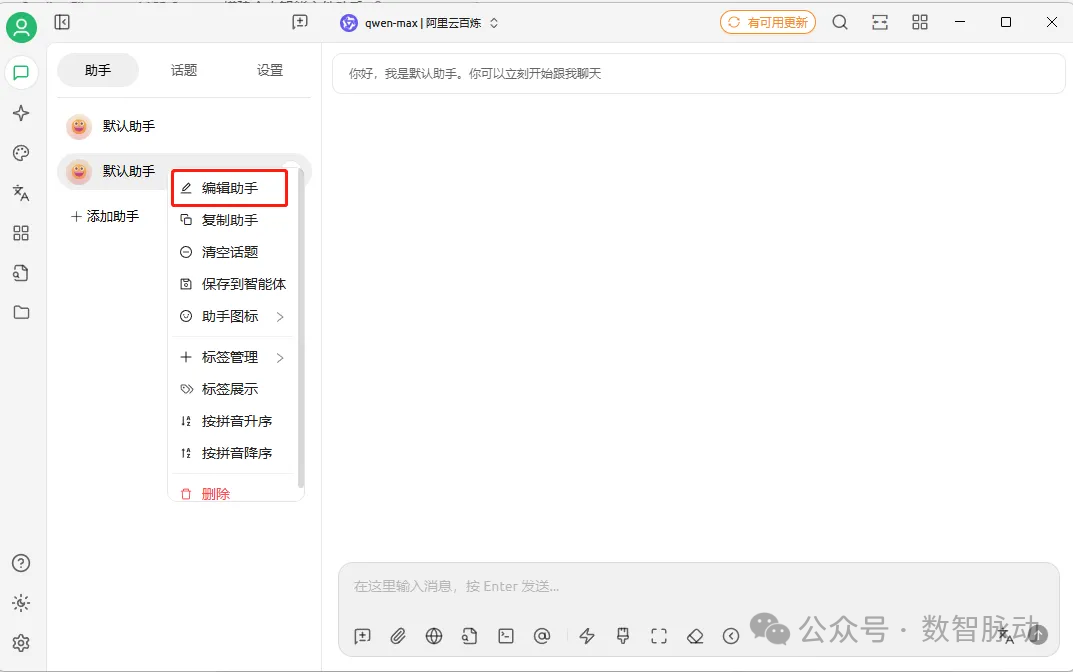

创建智能文件助手

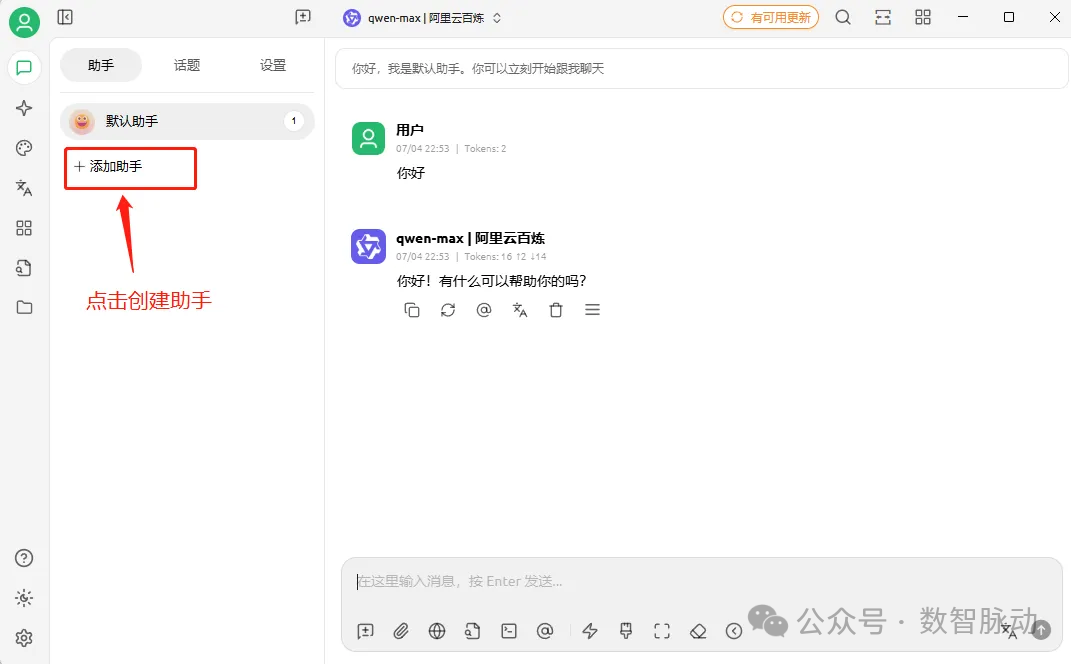

点击“添加助手”:

Cherry Studio 已内置了300+预设助手。选择一个预设助手:默认助手

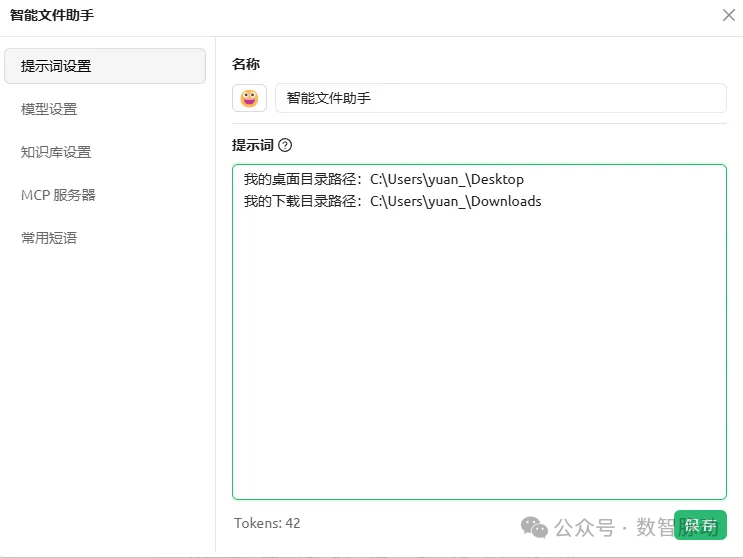

编辑新创建的默认助手,重命名为智能文件助手,添加系统提示词(为了让模型能准确识别文件目录路径,在系统提示词明确桌面和下载两个目录的路径):

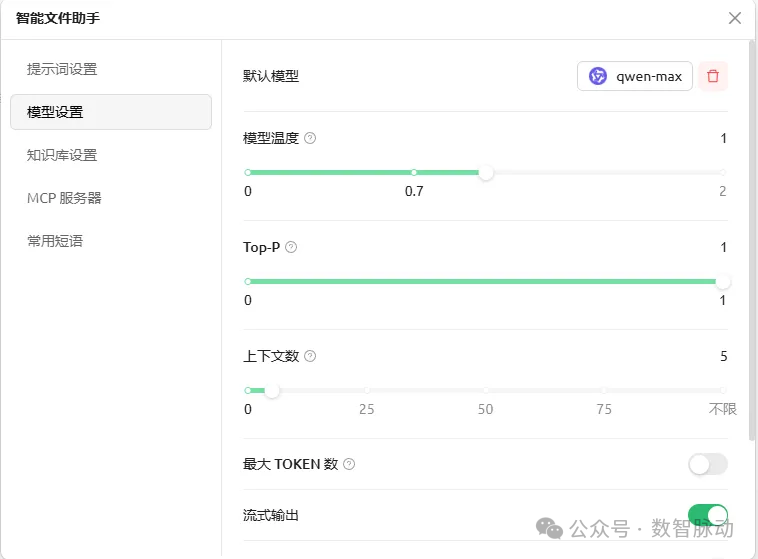

设置助手使用的模型,使用 qwen-max 模型:

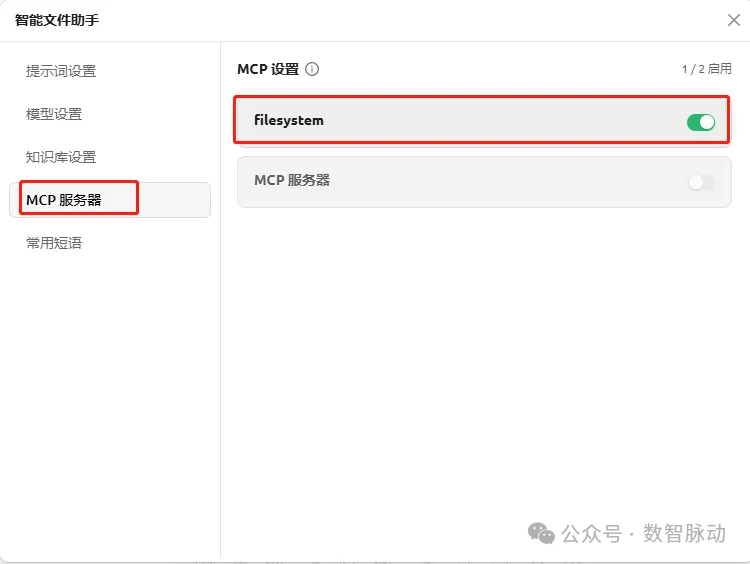

启用 MCP 服务器 filesystem:

使用测试

点击智能文件助手,开启与助手的对话。用户以自然语言的形式下指令,大模型识别用户意图,并通过 MCP 服务端对本地文件系统的文件进行读取、搜索、创建等操作。

1、列出目录下的全部文件:我的桌面下有哪些文件?

2、创建一个文件:在我的桌面上,创建一个文件,文件名为:report.txt

在桌面上成功创建了文件:

3、编辑文件:为什么天空是蓝色的?将这个问题的回答,保存到桌面上的 report.txt

问题回答自动地保存到桌面上的 report.txt 文件:

从上面的测试示例可见,用户以自然语言的形式下达指令,即可实现对本地文件系统的操作。

以上是基于Cherry Studio+Filesystem MCP Server 搭建个人智能文件助手的介绍。基于 AI 桌面客户端、第三方已实现的通用 MCP 服务器,我们可以快速地搭建满足个人需求的智能助手。

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此,我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包,现在将这份 LLM大模型资料 分享出来: 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

更多推荐

已为社区贡献116条内容

已为社区贡献116条内容

所有评论(0)