【动手学MCP从0到1】1. MCP是什么、环境安装和如何使用?

对MCP进行介绍,以及运行MCP所需要的环境配置,以及现有的MCP服务如何应用

MCP是什么、环境安装和如何使用?

1. MCP是什么

1.1 MCP介绍

MCP(Model Context Protocol)是Anthropic公司设计的一套开放协议,它就像Al模型的“万能接口”让大语言模型不仅能处理文本,还能连接数据库、搜索引擎、开发工具、办公软件等现实世界的数据和服务,真正实现“AI即服务”的落地应用。

再来了解下Al Agent的概念,AI大模型相当于人类的大脑,Agent相当于给这个大脑添加各种各样的能力,比如使用爬虫爬取数据后存储到数据库,只有拥有Agent能力的AL,才能去切入真实生活场号,帮助人类完成更多的事情。MCP则是使得Aaeni能力集成更加的方便,开发者只雲集中精力开发好具有某种能力的MCP Server.那么想用这个MCP Server的人只要通过很简单的配置就可以集成,从而降低Agent的使用门槛。

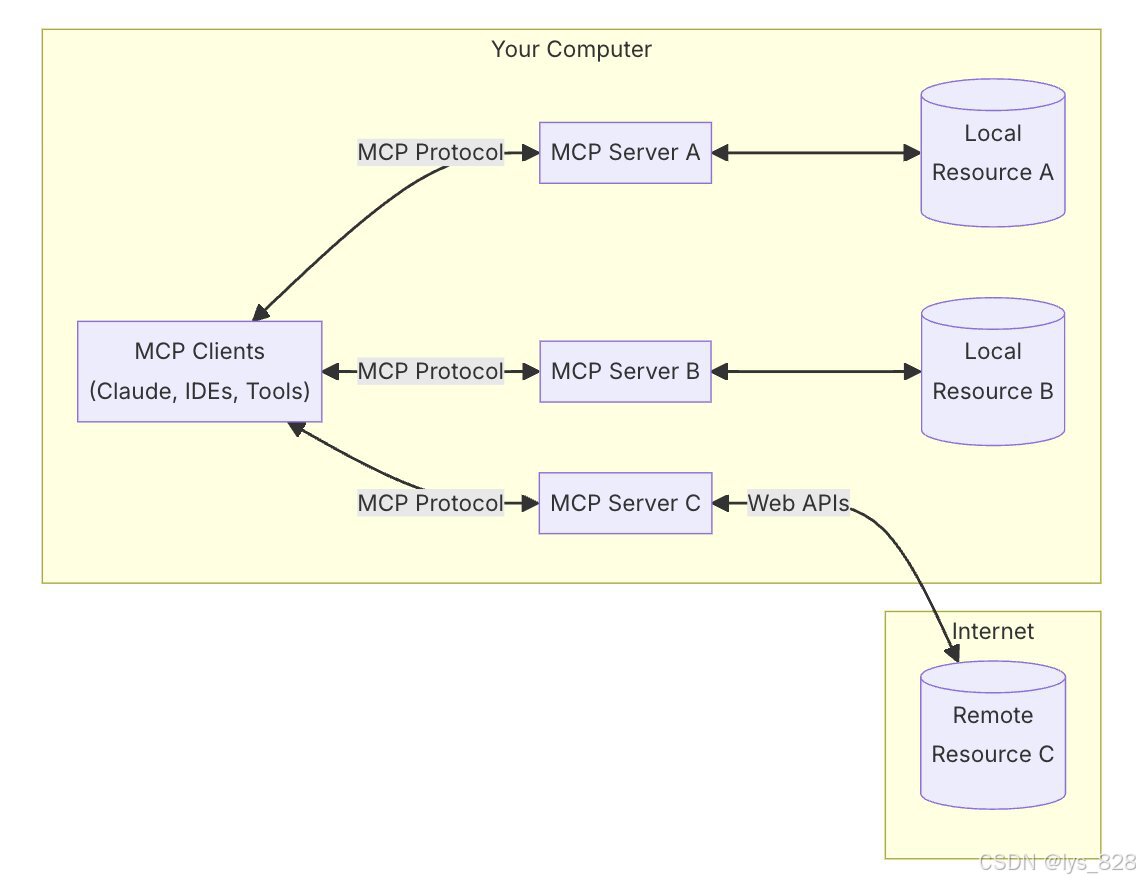

1.2 MCP结构

- MCP Host(宿主): 像Claude Desktop、CherryStudio、Cline、IDEs、或者一些想通过MCP协议连接数据的AI工具。

- MCP Clients(客户端): 能将用户的自然语言转换为MCP协议能识别的数据结构,并将AI返回的数据展示给用户

- MCP Servers (服务端): 对接真实世界的工具或数据源,执行实际操作(如查询数据库、发送邮件)。

- Local Data Sources: 本地数据源。比如文件、数据库,以及MCP服务器能连接到的服务。

- Remote Services: MCP服务器能通过互联网连接到的外部服务。比如获取实时天气服务。

1.3 典型应用场景

- 开发助手: 在IDE中,AI通过MCP直接调用Git命令、搜索代码库、运行测试。

- 数据分析: 自动连接Snowflake或Excel,执行查询并生成报告。

- 智能助理: 整合日历、邮件、Slack,实现会议安排、信息汇总等自动化任务。

- MCP的终极目标是成为A!领域的"TCP/P协议”–通过标准化交互,让任何A!模型都能安全、高效地融入人类工作流,随着生态发展,未来可能出现"MCP应用商店”,让非技术用户也能一键配置AI的“技能组合”。

1.4 哪些大模型支持MCP?

由于MCP底层使用了Function caling功能,所以只有那些支持了Function caling功能的大模型,才能稳定的支持MCP,目前有以下四款模型对Function Caling支

持得比较好:

- 深度求索:DeepSeekV3

- Anthropic: Claude 3.7

- OpenAl:GPT-40

- 谷歌:Gemini 2.5 Pro

如果想要判断某个模型是否支持MCP,可以在对应模型官网的描述信息中查看,或者在:https://openrouter.ai网站上搜索你想要的模型,然后看他的Supported parameters中是否有Tools,如果有,则支持,否则就不支持。

比如DeepSeekV3 0324模型支持MCP

比如DeepSeek R1模型不支持MCP。

2. 环境安装

由于MCP Server在运行过程中,要么通过nodejs来运行,要么通过Python来运行,所以我们需要先安装对应的环境。

2.1 安装nodejs环境

安装nodejs环境有两种方式,分别是直接安装和通过nvm安装。

-

- 通过nvm安装:安装方式,可参考:nvm下载安装教程(node.js 下载安装教程)。

-

- 直接安装:新手推荐可以在官网:https://nodejs.org/en,下载到最新的nodejs,然后双击即可安装。验证nodejs环境是否安装成功,需在Powershel上执行以下命令:

node -v

如果出现版本号,比如:v22.16.0(下载的最新版本会比这个版本号大一些),那么说明安装成功。此外,还要安装另外一个命令行工具:npx,但是由于npx在npm5.2.0版本以来就绑定到了npm中,因此npx无需单独安装。当然,如果在PowerShell(或命令行cmd)中执行npx命令后出现无法识别该命令的情况,那么需要通过以下命令安装:

npm install npx g

比如,下载nodejs好后,运行结果如下:

2.2 安装Python环境

在Python官网:https://www.python.org 下载最新的Python软件,双击安装即可在安装完Python后,还需要安装一个集包管理、虚拟环境、项目管理功能于一身的工具: uv,安装方式为打开Powershell终端,然后输入以下命令:

pip install uv

也可以直接下载anaconda替代原生Python(下载的版本需要在3.10~3.13之间,目前最新的是3.13版本)。下载后命令行输入python回车后,可以看到安装成功的版本信息

2.3 安装Git

由于后期一些MCP Host在下载MCP Server的时候会直接使用git命令从github上下载,所以我们需要提前安装好git软件。可以从:https://git-scm.com/下载,下载后双击安装即可。

验证安装成功的方式,也是在命令行中输入git,看是否有相应的版本信息返回,如下

3. 如何使用

目前官方和第三方已经开发了许多的MCP Server,我们只需将这些MCP Server集成到MCP Host中即可使用。(即便是目前没有学习如何通过编程实现MCP Server的开发,我们依然可以用到别人已经设置好的,体验MCP带来的便捷和高效性)

3.1 MCP Server

现在官方和社区已经开发了许多的MCP Server,可以在以下三个列表中找到:

- 1.官方MCP Server: https://github.com/modelcontextprotocol/servers

- 2.mcp.so: https://mcp.so/

- 3.MCP Market: https://mcpmarket.cn/

- 4.smithery.ai: https://smithery.ai/

- 5.github awesome-mcp-server: https://github.com/punkpeye/awesome-mcp-servers

3.2 CherryStudio

(1)选择大模型

CherryStudio是一个非常好用的AI工具,已经对MCP功能提供了支持。在这里可以下载到:https://cherry-ai.com/,在安装完成后,我们可以在设置界面中配置好大模型以及大模型对应的API Key。

其中API秘钥是在deepseek官网的开放平台上申请:https://platform.deepseek.com/api_keys,并且由于以API的形式访问deepseek,所以需要先在deepseek上充点钱才能使用。

(2)添加环境

由于CherryStudio没有使用我们系统的npx或uv来安装MCP Server,而是使用自带的命令安装,但是CherryStudio在安装完后又没有集成这两个命令,因此我们可以自行下载并后并解压出来后放到指定路径。教程如下:https://docs.cherry-ai.com/advanced-basic/mcp/install

(3)添加MCP服务

在CherryStudio中选择MCP服务器,然后点击添加服务,然后填入相关的信息:

点击保存,服务器名后出现绿色小圆点,说明已经配置成功了

重点在与参数配置上,比如我们选择官方提供的文件的系统管理MCP 服务:https://github.com/modelcontextprotocol/servers/tree/main/src/filesystem

此时在页面中向下拉,找到对应的参数设置,如下

将上面框框中的信息就可以复制在软件的参数设置中,第二行的路径参数为自己指定的可以操作的文件所在的路径,比如这里指定在桌面。

@modelcontextprotocol/server-filesystem

C:\Users\pc\Desktop

然后再回到聊天界面,首先选中MCP服务器,然后选择我们刚创建的MCP服务器。

可以进一步根据需求进行操作。

至此关于MCP的基础认知的内容就介绍完毕。此外还有其他的一些软件(或插件),比如VsCode+Cline、5ire、Cursor等可以直接使用已有的MCP Server。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)