【实战指南】DeepSeek大模型本地化部署全解析 小白也看得懂的deepseek本地化部署 - 图文版

通过本地化部署DeepSeek大模型,并通过Ollama或Chatbox AI与模型进行交互。本地部署不仅能够保护数据隐私,还能根据需求灵活调整模型参数,满足不同场景下的使用需求。如果你在部署过程中遇到任何问题,可以在评论区留言,我们将一起解决。小白也看得懂的deepseek本地化部署-CSDN博客。

摘要:本文详细讲解如何将深度求索(DeepSeek)大模型进行本地化部署,包含部署环境准备、ollama安装、下载并部署DeepSeek模型、下载Chatbox AI,助您快速构建企业级私有AI服务。(关键词:DeepSeek本地部署)

目录

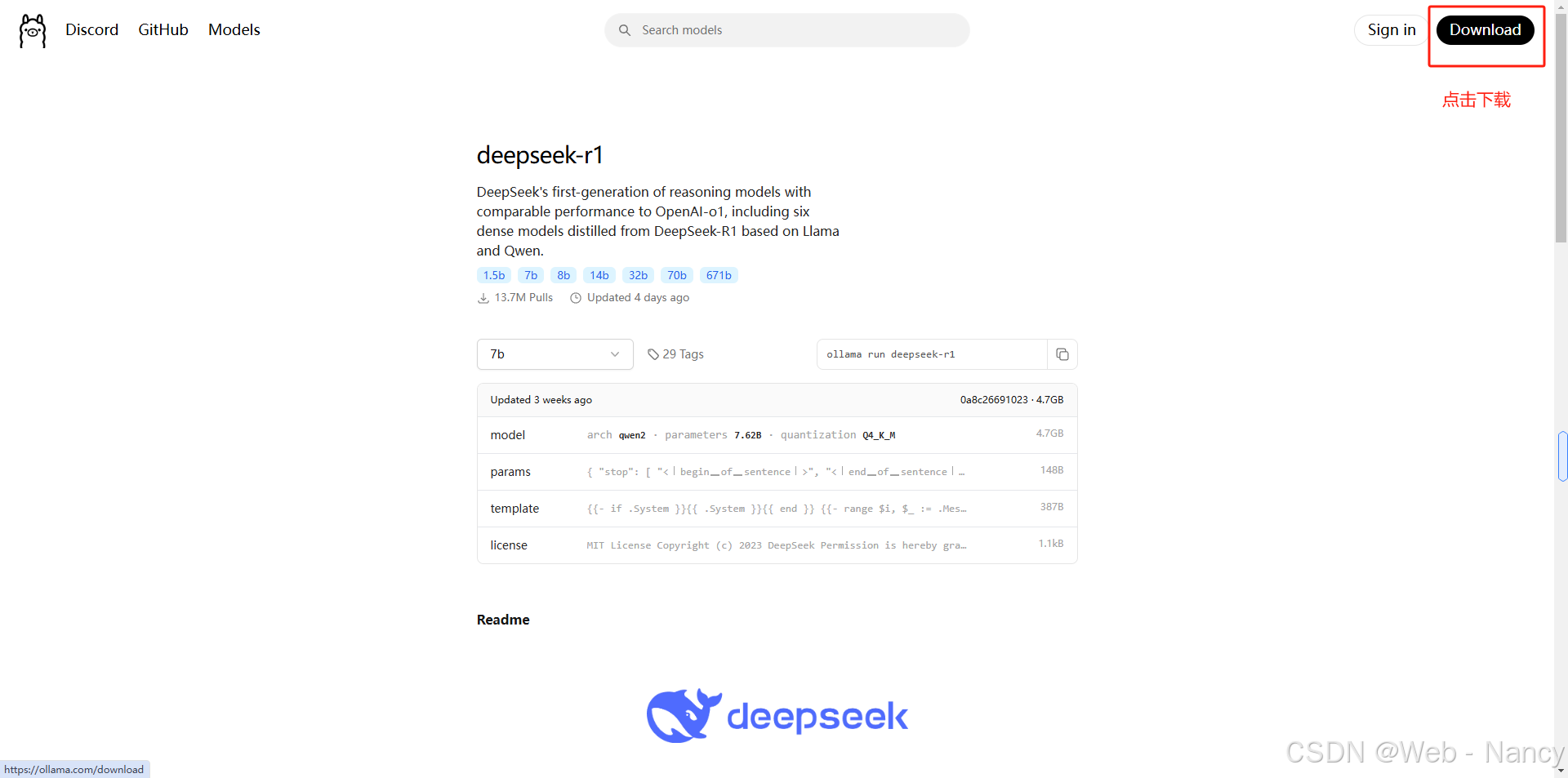

1. 安装allama:网址deepseek-r1,点击download进行安装

2. 下载安装包:根据你的操作系统选择对应的安装包。下载完成后,直接双击安装文件并按照提示完成安装。

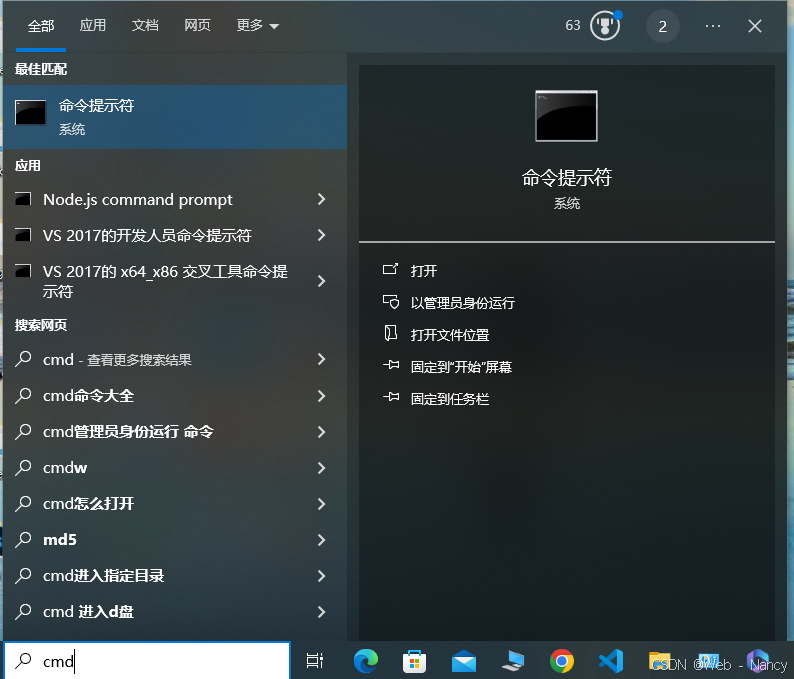

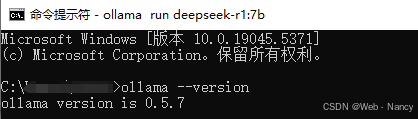

3. 验证安装:安装完成后,在操作栏的搜索框输入cmd回车打开终端输入以下命令,检查Ollama版本:

1. 点击下载,下载链接Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

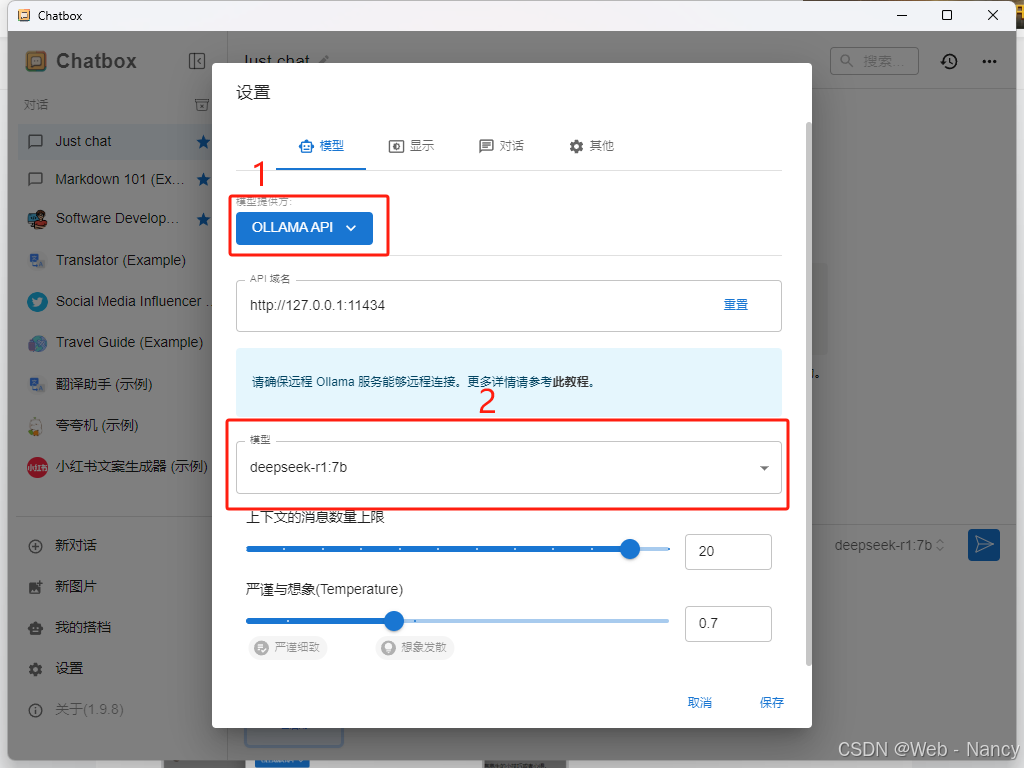

2. 下载完成后:进入Chatbox->设置->模型提供方选择:OLLAMA API,具体如图所示:

3.2 保存环境变量,最后就可以在chatbox 上提问啦!!!

一、DeepSeek本地化部署的价值

在数据安全需求日益增长的今天,本地化部署成为企业应用大模型的优选方案:

-

数据隐私保障:敏感数据不出内网

-

定制化开发:支持模型微调和业务适配

-

成本控制:长期使用成本低于API调用

-

离线可用:无网络依赖的稳定服务

二、部署环境准备

(一)硬件需求

- 最低配置:CPU(支持AVX2指令集)+ 16GB内存 + 30GB存储。

- 推荐配置:NVIDIA GPU(RTX 3090或更高)+ 32GB内存 + 50GB存储。

(二)软件依赖

- 操作系统:Windows、macOS或Linux。

- Docker:如果使用Open Web UI,需要安装Docker。

三、ollama安装

1. 安装allama:网址deepseek-r1,点击download进行安装

2. 下载安装包:根据你的操作系统选择对应的安装包。下载完成后,直接双击安装文件并按照提示完成安装。

3. 验证安装:安装完成后,在操作栏的搜索框输入cmd回车打开终端输入以下命令,检查Ollama版本:

ollama --version

如果出现 ollama version is 0.5.7 表示已经安装成功

四、下载并部署DeepSeek模型

Ollama支持多种DeepSeek模型版本,用户可以根据硬件配置选择合适的模型。以下是部署步骤:

(一)选择模型版本

-

入门级:1.5B版本,适合初步测试。

-

中端:7B或8B版本,适合大多数消费级GPU。

-

高性能:14B、32B或70B版本,适合高端GPU。

(二)下载模型

快捷键windows+R然后输入cmd,打开终端,以7b为例,输入下载指令:

ollama run deepseek-r1:7b

下载完成后,可以在终端直接输入你想问的问题,由于终端看起来不直接美观,所以需要借助chatbox AI界面,接下来安装chatbox AI👇

五、下载Chatbox AI

1. 点击下载,下载链接Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

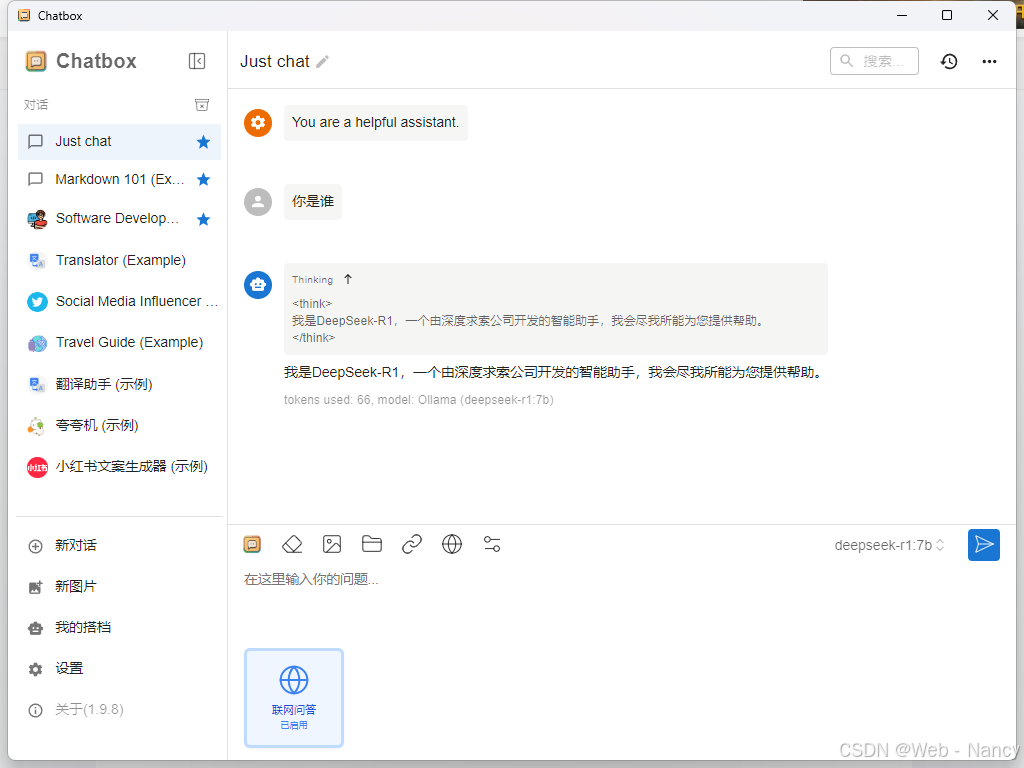

2. 下载完成后:进入Chatbox->设置->模型提供方选择:OLLAMA API,具体如图所示:

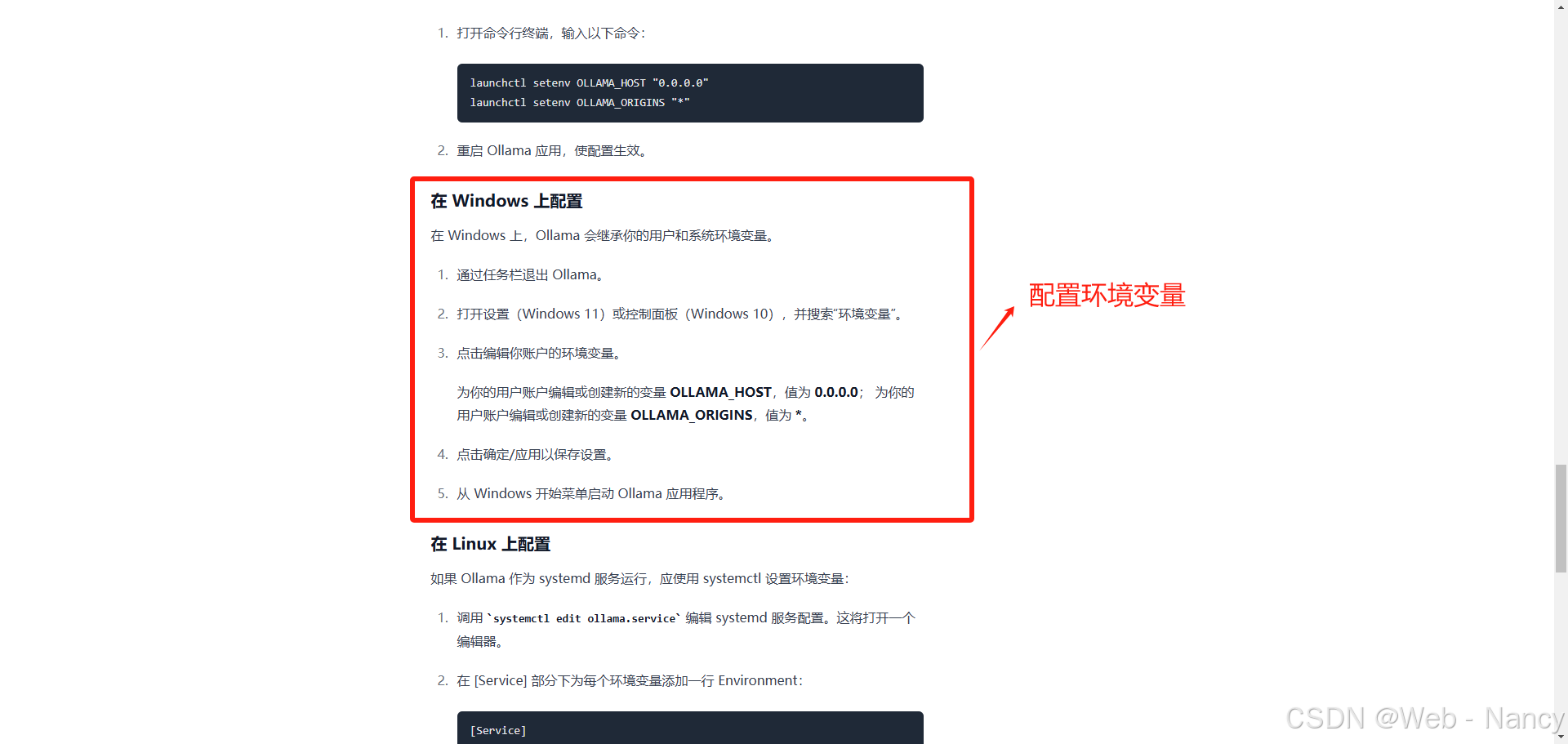

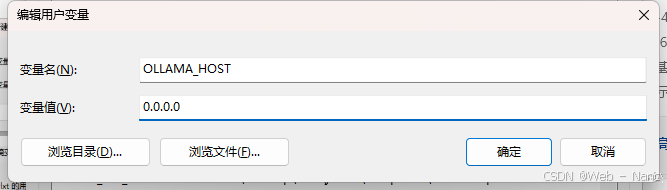

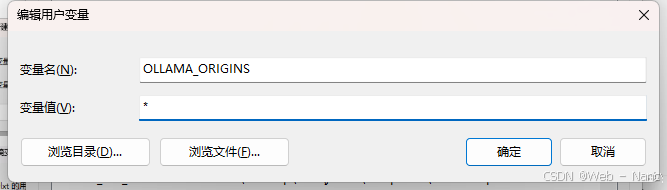

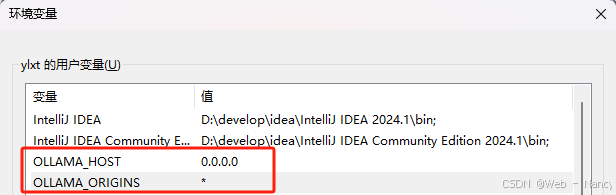

3. 环境变量配置:

3.1 以windows系统为例,配置环境变量即可:

3.2 保存环境变量,最后就可以在chatbox 上提问啦!!!

六、结语

通过本地化部署DeepSeek大模型,并通过Ollama或Chatbox AI与模型进行交互。本地部署不仅能够保护数据隐私,还能根据需求灵活调整模型参数,满足不同场景下的使用需求。如果你在部署过程中遇到任何问题,可以在评论区留言,我们将一起解决。

原文:

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)