Ollama安装部署及加载自定义量化Qwen大模型

Qwen/Qwen1.5-1.8B-Chat模型为例子ModelFile文件内容。

·

1.下载安装Ollama

curl -L https://ollama.com/download/ollama-linux-amd64.tgz -o ollama-linux-amd64.tgz

sudo tar -C /usr -xzf ollama-linux-amd64.tgz

2.ollama基本命令

# 启动 Ollama 服务

ollama serve

# 查看启动状况

ollama -v

# 运行模型

ollama run <模型名称>

# 删除本地已下载的模型

ollama rm <模型名称>

# 创建自定义模型

ollama create <自定义模型名称> --file <Modelfile路径>

# 停止Ollama服务

ollama stop

# 列出本地模型

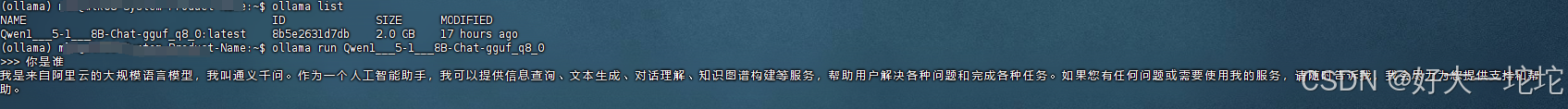

ollama list

3.加载自定义模型

- Qwen/Qwen1.5-1.8B-Chat 模型为例子

3.1 下载模型

3.2 量化转成GGUF格式

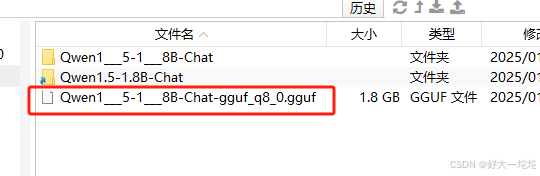

python convert_hf_to_gguf.py /home/llm/ai/model/Qwen/Qwen1___5-1___8B-Chat --outtype q8_0 --verbose --outfile /home/llm/ai/model/Qwen/Qwen1___5-1___8B-Chat-gguf_q8_0.gguf

- 如下

3.3 定义ModelFile文件

- ModelFile文件内容

FROM /home/llm/ai/model/Qwen/Qwen1___5-1___8B-Chat-gguf_q8_0.gguf

3.4 创建模型

ollama create Qwen1___5-1___8B-Chat-gguf_q8_0 --file ./ModelFile

3.5 运行模型

ollama run Qwen1___5-1___8B-Chat-gguf_q8_0

- 结果

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)