基于大模型的本地知识库搭建

本篇文章将介绍基于大模型来搭建本地知识库的流程。开源工具:MaxKB + Ollama。

本篇文章将介绍基于大模型来搭建本地知识库的流程。开源工具:MaxKB + Ollama

安装docker

在官网按需选择桌面版本,安装之后在docker中搜索maxkb的镜像:

搜索maxkb

点击 Run,等镜像下载完成之后,配置参数:

配置container

在 Volumes 这里,需要配置两个 Host path 来映射容器的固定目录:

# host path是本机目录,可以随意 /host/path1 ==> /var/lib/postgresql/data /host/path2 ==> /opt/maxkb/app/sandbox/python-packages

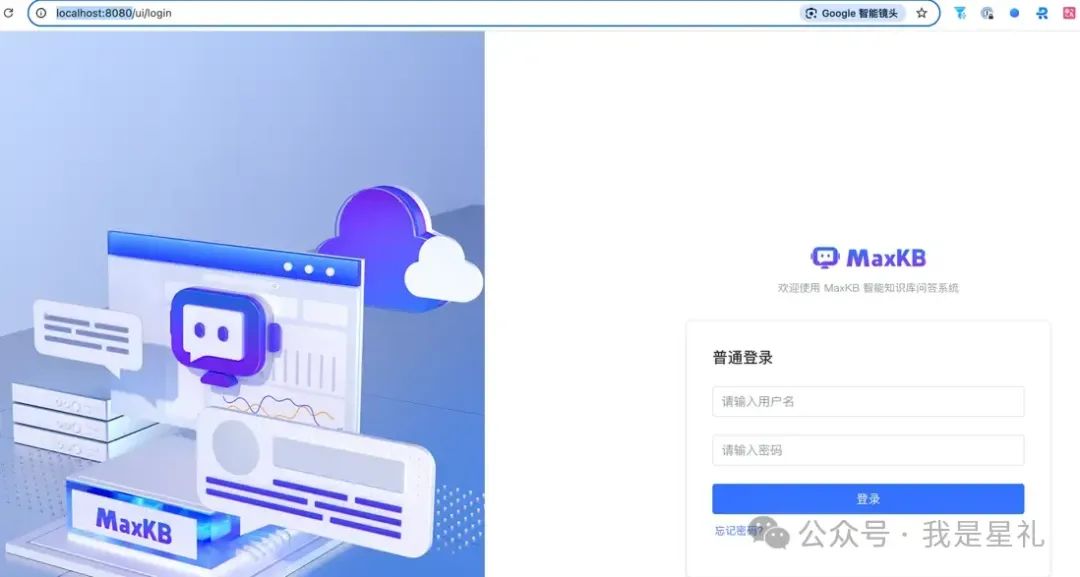

配置好之后,点击 Run,浏览器打开 localhost:8080,就能访问了:

登录页面

输入默认的用户名和密码登录即可:admin / MaxKB@123..

除了可视化配置之外,也可在 Terminal 运行命令启动:

docker run -d --name=maxkb --restart=always -p 5432:8080 \n -v ~/.maxkb:/var/lib/postgresql/data \n -v ~/.python-packages:/opt/maxkb/app/sandbox/python-packages \n cr2.fit2cloud.com/1panel/maxkb

创建知识库

登录之后,点击知识库 --> 创建知识库:

创建知识库

然后选择 Markdown 格式的文档上传:

上传文件

示例的 README.md 是介绍组件 QueryTable组件的使用。可以把需要上传的文档放在同一个目录一起上传,待文件上传完成之后,就完成了知识库的创建。

添加Ollama

物料上传之后,去系统管理 --> 模型设置,配置本地私有模型:

模型设置

maxkb 不仅支持常见的公有模型,也支持Ollama等私有模型。对于非敏感数据,也可以选择线上的公有模型。私有模型我们选择 ollama 进行配置。

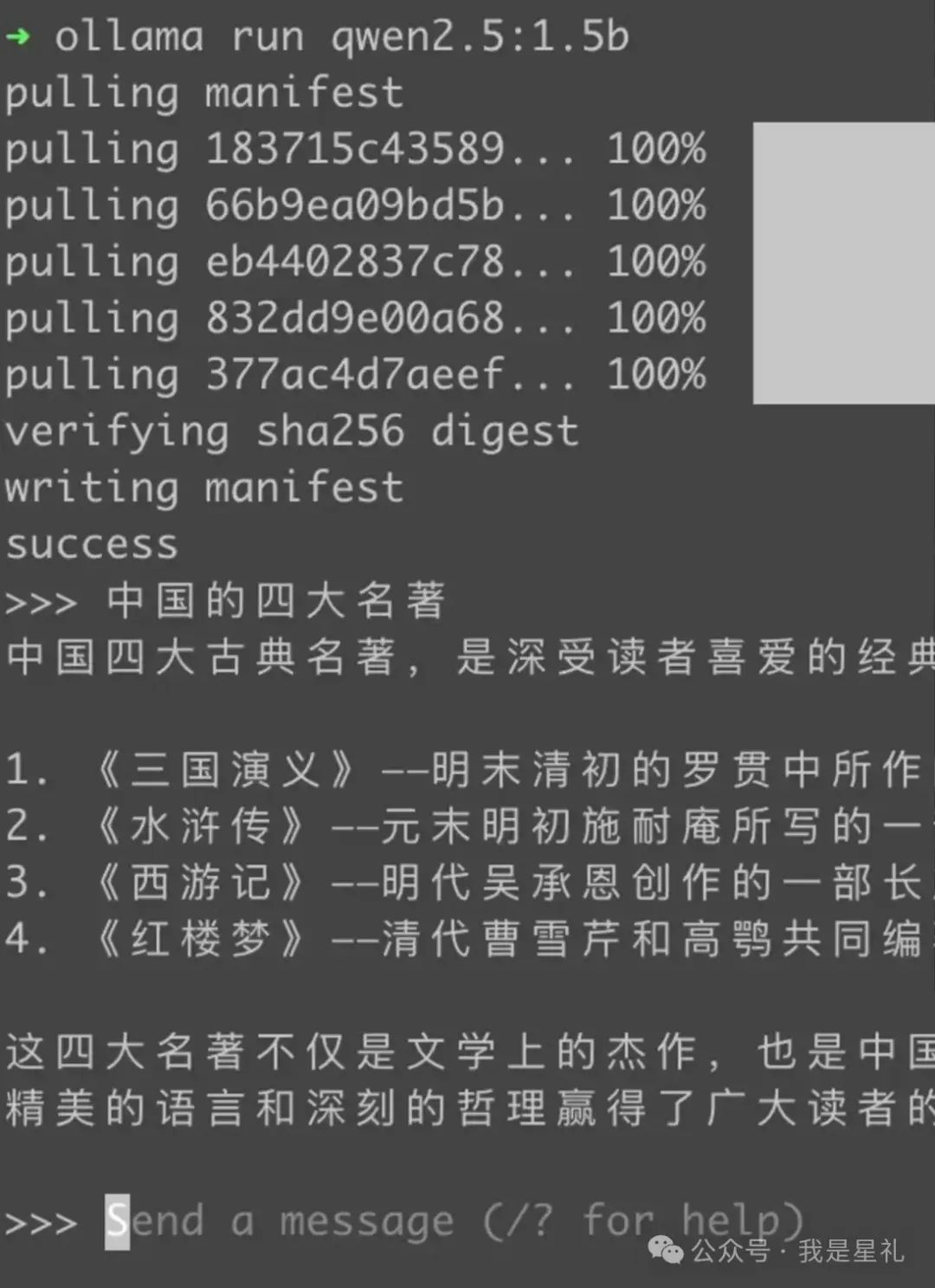

先去官网下载 ollama,安装之后可以跑一下中文模型 qwen2.5:

qwen2.5

因为物料都是中文,所以MaxKB也选择中文开源模型 qwen2.5:

添加Ollama

API域名用 http://host.docker.internal:11434,host.docker.internal 相当于容器内的 locahost, 11434 是 ollama 模型的默认端口,API Key 随便填一个就行,最后点「添加」:

创建本地模型

如果是线上模型,域名和key就用模型对应的域名和key

创建应用

知识库和本地模型都配置完成之后,就需要创建一个应用将知识库和本地模型关联起来:

创建应用

「AI模型」选择刚创建好的本地模型。应用创建好之后,会有一个本地访问连接:

应用界面

打开这个链接,输入问题:QueryTable组件怎么用。可以看到其回复中会引用知识库 component 中的内容:

结果测试

至此,我们已完成基于本地大模型的知识库搭建。

👉获取方式:

这份完整版的大模型 LLM 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

😝有需要的小伙伴,可以Vx扫描下方二维码免费领取🆓

更多推荐

已为社区贡献45条内容

已为社区贡献45条内容

所有评论(0)