一文讲清大模型:API、Function Call、MCP、MoE、MoA、Agent与多智能体系统的协作关系、工作机制

人工智能技术的快速发展催生了一系列创新架构和协作机制,形成了复杂而强大的AI技术栈。从基础的API接口到高级的多智能体系统,这些技术组件相互协作、相互促进,共同构建了现代AI应用的技术基础。本报告深入探讨API、Function Call、MCP、MoE、MoA、Agent与多智能体系统的工作机制、架构设计和协作关系,旨在全面呈现AI技术栈的发展现状和未来趋势。

引言

人工智能技术的快速发展催生了一系列创新架构和协作机制,形成了复杂而强大的AI技术栈。从基础的API接口到高级的多智能体系统,这些技术组件相互协作、相互促进,共同构建了现代AI应用的技术基础。本报告深入探讨API、Function Call、MCP、MoE、MoA、Agent与多智能体系统的工作机制、架构设计和协作关系,旨在全面呈现AI技术栈的发展现状和未来趋势。

一、API与Function Call:AI能力输出的基础层

1.1 API接口:AI能力的标准化封装

API(应用程序编程接口)是AI系统对外提供服务的标准化接口,通过REST或GraphQL等协议,实现AI模型能力的封装与调用。API层负责处理身份验证、请求限制、负载均衡等功能,使开发者能够以统一的方式访问AI能力。

1.2 Function Call工作机制

Function Call(函数调用)是大语言模型(LLM)与外部工具交互的重要机制,允许模型在对话过程中调用预定义的外部函数。

Function Call工作原理:

- 函数定义:开发者以JSON格式描述函数名称、参数和用途

- 用户查询:用户提出自然语言请求

- 模型理解与分析:LLM解析用户意图,决定是否需要调用函数

- 参数生成:模型生成符合函数签名的参数(通常为JSON格式)

- 函数调用:开发者系统接收函数调用请求并执行相应操作

- 结果返回:执行结果返回给模型,模型据此生成最终回答

图1:Function Call工作流程,展示了从用户输入到模型分析再到函数执行的完整过程

Function Call使LLM能够执行超出其内部能力的操作,如查询数据库、调用第三方API、执行复杂计算等,从而大幅扩展了AI应用的能力边界。

二、MCP:模型上下文协议

2.1 MCP概述与价值

模型上下文协议(Model Context Protocol,MCP)是由Anthropic在2024年推出的一种开放标准,旨在为AI模型与外部资源提供统一的连接方式。MCP被形象地称为"AI领域的USB-C接口",为AI模型与各类工具和数据源的交互提供了标准化机制。

2.2 MCP架构设计与工作原理

MCP采用了一种客户端-服务器架构,将LLM与资源之间的通信划分为三个主要部分:

- 客户端:负责发送请求给MCP服务器

- 服务器:接收请求并转发给相应的资源

- 资源:执行具体的操作并返回结果

图2:MCP架构设计,展示了客户端、服务器与资源之间的交互流程

2.3 MCP与传统API的区别

MCP相比传统的API和Function Call,具有以下优势:

- 统一接口:提供标准化的接口,降低了集成不同工具的复杂性

- 模型自主性:模型可以自主决定何时何地调用哪个工具

- 上下文保持:在多次交互中保持上下文连贯性

- 无厂商绑定:是一个开放标准,不绑定特定模型或供应商

MCP实现了对Function Call的进一步抽象和标准化,使AI模型能够更灵活、更高效地访问和利用外部资源。

三、MoE:混合专家模型

3.1 MoE基本概念

混合专家模型(Mixture of Experts,MoE)是一种神经网络架构设计策略,通过将多个模型(“专家”)组合在一起,以提高整体性能和效率。MoE的核心思想是将复杂任务分解为子任务,让专门的"专家"处理各自擅长的部分。

3.2 MoE工作机制

MoE架构主要由两个核心组件组成:

- 专家网络(Experts):多个独立的神经网络,每个专注于特定类型的输入或任务

- 门控网络(Gating Network):负责决定将输入分配给哪个专家处理

图3:MoE架构图,展示了门控网络如何分配任务给不同专家

图3:MoE架构图,展示了门控网络如何分配任务给不同专家

3.3 MoE在大语言模型中的应用

在大型语言模型(LLM)中,MoE通常用于替代传统Transformer架构中的前馈网络(FFN)层。具体工作流程如下:

- 输入处理:输入token经过自注意力层处理

- 门控分配:门控网络评估输入,决定激活哪些专家

- 专家处理:被选中的专家处理输入并生成结果

- 结果融合:门控网络根据分配权重将各专家结果融合

图4:MoE在Transformer架构中的应用,红框部分为MoE替代的FFN层

图4:MoE在Transformer架构中的应用,红框部分为MoE替代的FFN层

MoE架构使大模型能够在保持性能的同时显著减少计算资源消耗,是当前大型语言模型发展的重要方向。

四、MoA:混合智能体模型

4.1 MoA概念与背景

混合智能体模型(Mixture of Agents,MoA)是一种新兴的AI架构,由Together AI提出。与MoE专注于模型内部结构不同,MoA关注的是多个完整LLM智能体之间的协作,通过集成多个不同模型的优势来增强整体性能。

4.2 MoA架构设计

MoA采用分层架构设计,每层包含多个LLM代理(Agents),各代理协同工作以产生更优质的结果:

- 分层结构:MoA通常由多层组成,每层包含多个LLM代理

- 信息流动:每个代理使用前一层所有代理的输出作为辅助信息

- 结果融合:通过特定机制融合各代理的结果,产生更优质的输出

图5:MoA分层架构设计,展示了多层代理协作的工作流程

图5:MoA分层架构设计,展示了多层代理协作的工作流程

4.3 MoA工作机制

MoA的工作流程具体如下:

- 初始输入:用户查询输入到第一层各代理

- 多代理处理:每个代理独立处理输入并生成响应

- 信息交互:每层代理的输出作为下一层代理的补充信息

- 结果聚合:最后一层代理的输出经过融合机制,生成最终响应

MoA的优势在于能够结合不同模型的强点,克服单一模型的局限性,使开源模型的集体表现可以接近或超越闭源巨头模型的性能。

五、Agent与多智能体系统

5.1 Agent的定义与特点

AI Agent(智能体)是能够感知环境、制定决策并采取行动以实现特定目标的AI系统。Agent的核心特点包括:

- 自主性:能够独立判断和行动

- 感知能力:能够感知和理解环境

- 目标导向:行为由明确的目标驱动

- 学习适应:能够从经验中学习和改进

5.2 多智能体系统架构

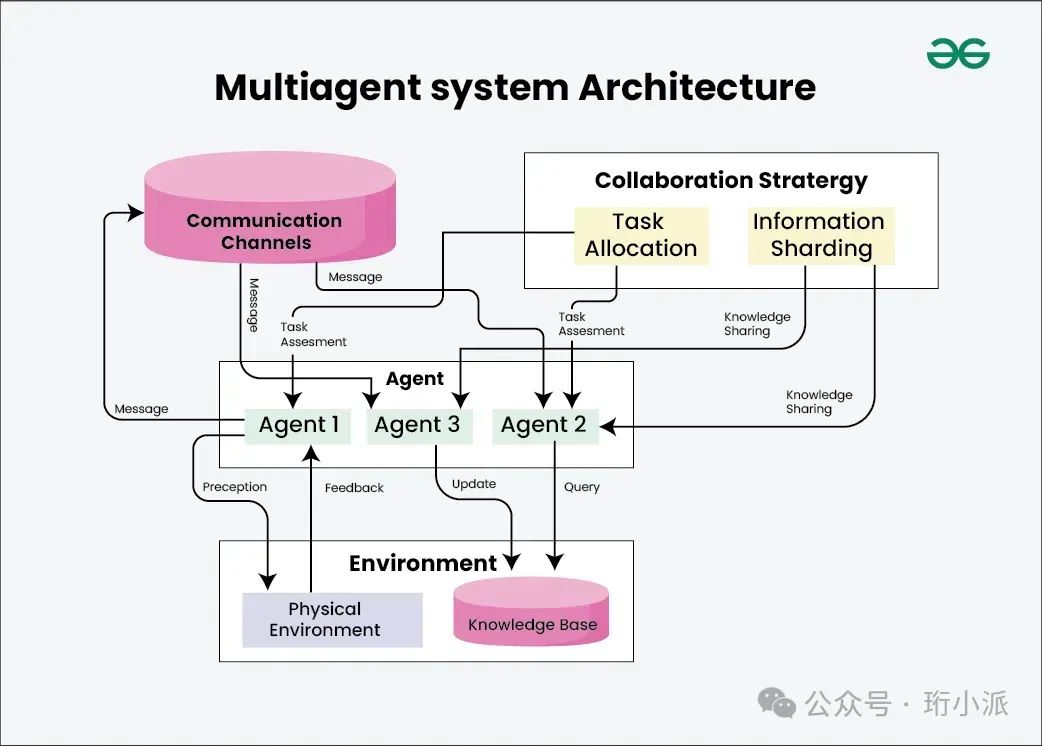

多智能体系统(Multi-Agent System,MAS)是由多个智能体组成的协作网络,通过特定协调机制进行交互以实现集体智能。

图6:多智能体系统架构图,展示了不同智能体之间的协作关系

图6:多智能体系统架构图,展示了不同智能体之间的协作关系

5.3 多智能体系统协作机制

多智能体系统的协作机制主要包括:

- 通信机制:智能体间信息交换的标准协议

- 协调机制:任务分配与资源调度的规则

- 角色分配:基于专长和能力分配不同角色

- 冲突解决:处理智能体间目标或资源冲突

- 集体决策:综合多个智能体的判断形成最终决策

图7:多智能体系统协作机制示意图

图7:多智能体系统协作机制示意图

六、技术栈组件间的协作关系

6.1 垂直协作:从API到多智能体系统

AI技术栈的各组件形成了一个垂直协作关系:

- API层:提供基础能力接口

- Function Call:实现模型与外部工具的连接

- MCP:标准化模型与资源的交互协议

- MoE/MoA:优化模型内部结构或智能体协作方式

- Agent:封装完整的感知-决策-行动能力

- 多智能体系统:构建智能体协作网络

这种垂直协作使AI系统能够从简单的API调用发展为复杂的智能体协作网络,实现更强大的功能。

6.2 水平协作:不同技术路线的互补

同时,不同技术路线之间也形成了水平协作关系:

- MoE与MoA:前者优化模型内部结构,后者优化智能体间协作

- Function Call与MCP:前者提供基础调用能力,后者提供标准化协议

- 单Agent与多智能体系统:前者专注单体能力,后者关注协作效果

这种水平协作使不同技术路线能够互补,共同推动AI技术进步。

七、技术栈工作机制综合图

以下是AI技术栈各组件的工作机制综合图,展示了从API到多智能体系统的完整技术链路:

图8:AI技术栈工作机制综合图,展示了从底层API到高级智能体系统的层次关系

图8:AI技术栈工作机制综合图,展示了从底层API到高级智能体系统的层次关系

八、未来发展趋势与挑战

8.1 发展趋势

- 标准化协议普及:MCP等标准化协议将更广泛地应用

- 智能体自组织:多智能体系统将发展出更高级的自组织能力

- 混合架构融合:MoE和MoA等技术将相互融合,形成更优的混合架构

- 领域专用化:针对特定领域的专用智能体架构将涌现

- 可解释性增强:技术栈各层将加强可解释性设计

8.2 面临挑战

- 资源消耗:多智能体系统的计算和资源消耗问题

- 协作效率:智能体间协作的效率和一致性问题

- 安全与隐私:复杂技术栈带来的安全与隐私挑战

- 评估标准:缺乏统一的评估标准和框架

- 技术整合:不同技术组件的无缝整合仍面临困难

结论

AI技术栈正在从简单的API调用模式向复杂的多智能体协作系统演进,API、Function Call、MCP、MoE、MoA、Agent与多智能体系统共同构成了现代AI应用的技术基础。这些组件通过垂直和水平的协作关系,实现了从基础能力到高级智能的逐层递进。

随着技术的不断发展,我们可以预见未来的AI系统将更加复杂、高效和智能,各组件之间的协作将更加紧密和高效。同时,资源消耗、协作效率、安全隐私等挑战也需要研究者和开发者共同面对和解决。

通过深入理解AI技术栈的工作机制和协作关系,我们能够更好地把握AI技术发展的脉络,为未来AI系统设计和应用提供更坚实的理论基础和实践指导。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)