RAG 效果不佳?试试 MCP+数据库(Text2SQL):提升大模型结构化数据检索精度的实战指南

今天,我们将探讨一种基于 MCP(模型上下文协议)的新思路,结合数据库来提高大模型检索外部知识(尤其是结构化数据)的精度。通过实际测试,这种方法的效果确实比传统 RAG 好很多。

在 AI 大模型日益普及的今天,如何让模型更精准地利用外部知识,一直是研究的热点。检索增强生成(RAG)是当前的主流方案,但其效果有时不尽如人意。今天,我们将探讨一种基于 MCP(模型上下文协议)的新思路,结合数据库来提高大模型检索外部知识(尤其是结构化数据)的精度。通过实际测试,这种方法的效果确实比传统 RAG 好很多。

市面上关于 MCP 的讲解不少,但大多停留在概念层面。最近我深入体验了 MCP,切身感受到它作为一项有意义的技术标准,确实能帮助我们解决许多以往棘手的问题。因此,本文将从一个实际案例出发,带大家深入了解 MCP。

在开始之前,我们先来看看当前流行的 RAG 技术存在哪些瓶颈。

一、背景:RAG 的局限性

RAG(Retrieval-Augmented Generation)通过结合信息检索和生成模型,旨在解决大模型在知识准确性、上下文理解和信息时效性方面的挑战。在之前的分享中(例如如何在本地部署带知识库的 DeepSeek),我们探讨过如何引入本地知识库。

然而,许多人可能对 RAG 的能力有所高估,认为只要将外部知识通过 RAG 导入,模型就能完美掌握并回答相关问题。但实践是检验真理的唯一标准,实际尝试后会发现,RAG 的精准度往往不达预期。

从 RAG 的技术原理来看,主要存在以下问题:

- 检索精度不足:RAG 的核心流程是:知识向量化 -> 存入向量数据库 -> 用户问题向量化 -> 向量相似度匹配 -> 大模型总结检索内容。在这个过程中,大模型主要扮演“总结者”的角色,信息检索的准确性很大程度上依赖于向量匹配。这可能导致检索结果包含不相关内容(低精确率)或遗漏关键信息(低召回率)。

- 生成内容不完整:RAG 通常处理的是文档切片(chunks)。由于切片的局部性,模型无法获取文档全貌。因此,在回答需要整合多部分信息的问题(如“列举 XXX”、“总结 XXX”)时,结果往往不完整。

- 缺乏全局观:RAG 难以判断回答一个问题需要多少个文档切片,也无法理解文档之间的关联和依赖。例如,法律条文中,新的司法解释可能覆盖旧条款,但 RAG 很难判断哪个信息是最新的、最权威的。

- 多轮检索能力弱:对于需要多步骤推理的任务,往往需要执行多轮、多角度的查询,而传统 RAG 在这方面的能力较弱。

尽管近期出现了一些改进技术,如 GraphRAG、KAG 等,尝试解决上述部分问题,但这些技术目前尚不成熟。总的来说,当前的 RAG 技术距离我们的理想预期仍有较大差距。

下面,我们将介绍一种新的方案:利用 MCP 结合数据库来提升结构化数据的检索精度,其效果接近于 Text-to-SQL,并且实测检索效果优于 RAG。

例如,我们有这样一份学生信息表:

我们用一个稍复杂的查询来测试:“身高在 180cm 到 190cm 之间的女生有哪些?” 通过 MCP + 数据库的方式,可以得到更精确的结果。

二、理论:了解 MCP 的基础知识

在深入 MCP 之前,我们必须先了解一个重要的前置概念:Function Call。

2.1 Function Call(函数调用)

传统的 AI 大模型,可以想象成一个知识渊博但被困在“信息孤岛”中的专家。它只能依赖自身训练数据中的知识来回答问题,无法直接获取实时数据或与外部系统(如数据库、API)交互。

Function Call 是 OpenAI 在 2023 年提出的一个重要概念。它赋予了大模型与外部世界“对话”的能力,就像给模型配备了一个“外挂工具箱”。当模型遇到自身知识无法解决的问题时(例如查询实时天气、访问数据库最新记录),它可以主动调用预定义的外部函数(工具),获取所需信息后,再整合生成最终回答。

我们在 Coze 这类零代码 Agent 搭建平台上看到的各种“插件”,其底层实现大多基于 Function Call 的思想。

Function Call 无疑极大地扩展了大模型的能力边界,但它也存在显著的缺点,尤其是在 MCP 出现之前:

- 高昂的实现成本:

- 模型支持:首先,需要大模型本身稳定支持 Function Call 调用。并非所有模型都具备此能力(例如在 Coze 中选择某些模型时会提示不支持插件)。

- 专门训练:模型通常需要经过针对 Function Call 的微调才能稳定使用。标准的 ShareGPT 风格数据集中就包含了用于 Function Call 训练的特殊字段(

function_call,observation,tools)。

- 协议碎片化:OpenAI 最初提出 Function Call 时,并未将其定位为通用标准。因此,后续虽然许多模型也支持了类似功能,但各自的实现方式(如参数格式、触发逻辑、返回结构等)往往不同。这意味着开发者为实现一个 Function Call 工具,可能需要为 GPT、Claude、DeepSeek 等不同模型分别进行适配,开发和维护成本非常高。

这大大提高了 AI Agent 的开发门槛,导致过去我们更多地依赖 Dify、Coze 等封装好的平台来构建 Agent。

Function Call 核心特点与痛点:

- 特点:

- 模型专属:不同模型的调用规则各异。

- 即时触发:模型解析用户意图后直接调用。

- 简单直接:适合单一、明确的功能调用(如“查天气”)。

- 痛点:

- 协议碎片化:需要为每个模型开发适配层(类似不同手机的充电接口 Lightning/USB-C,互不通用)。

- 功能扩展难:新增工具可能需要重新训练模型或调整接口。

2.2 MCP(模型上下文协议)

MCP(Model Context Protocol)是由 Anthropic 公司(Claude 模型的开发者)提出的一个开放标准协议,旨在解决 AI 模型与外部数据源、工具交互的标准化难题。

如果说 Function Call 是为特定模型打造的“专用接口”,那么 MCP 则致力于成为一个**“通用接口”**(类似于 USB 接口)。它定义了一套统一的规范,让 AI 模型无论是连接数据库、调用第三方 API,还是访问本地文件,都可以通过这套标准协议来完成交互。

MCP 的目标是让 AI 模型与外部工具、数据源的连接变得标准化、可复用。

MCP 的发展历程颇具戏剧性:最初只有 Anthropic 自家的 Claude 客户端支持,并未引起广泛关注。但随着 Cursor(与 Anthropic 关系密切的代码编辑器)的集成和推广,以及各类插件、工具的跟进支持,MCP 的影响力逐渐扩大。特别是近期 AI Agent 概念火热(如 Manus),以及连 OpenAI 也宣布支持 MCP,这标志着 MCP 正在逐步成为 AI 工具调用的**“行业标准”**。

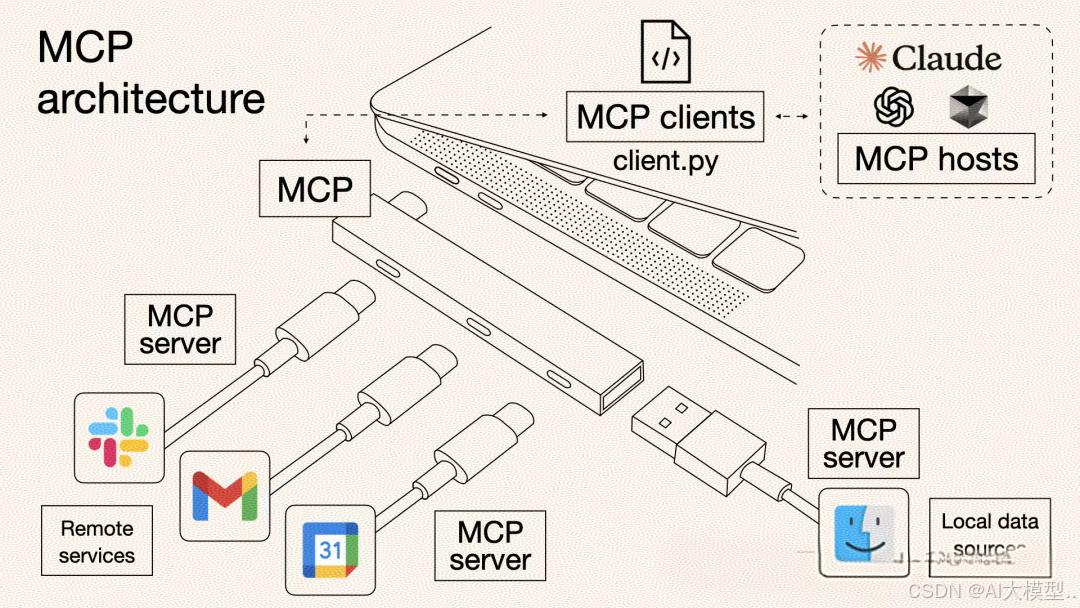

MCP 架构简述:

- MCP Host (如 Claude Desktop, Cursor): 用户使用的客户端工具,内置了 MCP Client。

- MCP Client: 负责通过标准 MCP 协议与 MCP Server 通信。

- MCP Server: 由第三方开发者提供,实现了与特定外部资源(数据库、浏览器、本地文件等)交互的逻辑。它接收来自 MCP Client 的请求,执行操作,并将结果通过标准 MCP 协议返回。

MCP 的核心价值:

- 标准化开发:开发者只需按照 MCP 协议开发一次 Server,理论上就能被所有兼容 MCP 的 Host 使用,无需为不同模型或平台重复编写适配代码,显著降低开发工作量。

- 生态共享:开发出的 MCP Server 可以开放共享,减少开发者的重复劳动。例如,一个数据库查询插件,无需在 Coze 和 Dify 上分别实现,只要两者都支持 MCP,就能使用同一个 Server。

MCP 核心特点与价值:

- 特点:

- 协议标准化:统一工具调用的格式(请求、响应、错误处理)。

- 生态兼容性:一次开发,多处运行(对接所有兼容 MCP 的模型/客户端)。

- 动态扩展:新增工具无需修改模型代码,实现“即插即用”。

- 核心价值(解决三大痛点):

- 数据孤岛 → 打通本地/云端数据源。

- 重复开发 → 工具开发者只需适配 MCP 协议。

- 生态割裂 → 形成统一的工具市场。

- 类比:USB-C 接口,让手机、电脑、外设通过统一标准互联互通。

2.3 MCP 对比 Function Call

| 特性 | Function Call | MCP (Model Context Protocol) |

|---|---|---|

| 定义 | 模型调用外部 API 的特定实现 | 模型与外部工具交互的开放标准协议 |

| 标准化 | 低 (各模型实现不同) | 高 (统一规范) |

| 开发成本 | 高 (需为不同模型适配) | 低 (一次开发,多处使用) |

| 生态系统 | 碎片化 | 统一化 (潜力) |

| 调用方式 | 模型直接调用预定义函数 | 客户端通过协议与 Server 交互 |

| 灵活性 | 相对固定 | 更灵活,易于扩展新工具 |

| 类比 | 不同品牌手机充电口 (Lightning/USB-C) | 通用 USB-C 接口 |

三、尝试:学会 MCP 的基本使用

要使用 MCP 技术,我们需要两个核心组件:一个支持 MCP 协议的客户端 (Host),以及满足我们需求的 MCP 服务器 (Server)。然后在客户端中配置并调用这些服务。

3.1 MCP 客户端 (Host)

根据 MCP 官方文档 (https://modelcontextprotocol.io/clients),目前已有一系列工具支持 MCP 协议,主要分为几类:

- AI 聊天工具:如 5ire, LibreChat, Cherry Studio

- AI 编码工具:如 Cursor, Windsurf, Cline

- AI 开发框架:如 Genkit, GenAIScript, BeeAI

官方文档还将客户端支持的 MCP 能力划分为五种(目前最常用且支持最广泛的是 Tools):

- Tools: Server 暴露可执行功能,供 LLM 调用与外部系统交互。

- Resources: Server 暴露数据内容,供客户端读取作为 LLM 上下文。

- Prompts: Server 定义可复用提示模板,引导 LLM 交互。

- Sampling: Server 借助客户端向 LLM 发起请求,实现复杂智能行为。

- Roots: 客户端指定路径,告知 Server 关注哪些资源或去哪里查找。

3.2 MCP Server

MCP Server 可以简单理解为:一个轻量级程序,它通过标准化的 MCP 协议向客户端“暴露”特定的功能或数据访问能力,让大模型能够间接调用。

常见的 MCP Server 类型:

- 文件和数据访问类:允许模型操作本地文件或数据库(如

FileSystem MCP Server,MongoDB MCP Server)。 - Web 自动化类:允许模型控制浏览器执行任务(如

Puppeteer MCP Server)。 - 三方工具集成类:允许模型调用外部平台 API(如

高德地图 MCP Server)。

在哪里可以找到你需要的 MCP Server?

- 官方 Server 仓库: https://github.com/modelcontextprotocol/servers

- 包含官方示例、官方集成和社区开发的 Server。

- MCP.so: https://mcp.so/

- 一个第三方 MCP Server 聚合平台,收录了大量 Server,并提供配置示例。

- MCP Market: https://mcpmarket.cn/

- 界面友好,访问速度较快,支持按类型筛选。

3.3 在 Cherry Studio 中尝试 MCP

这部分笔者之前专门出过教程,所以简化

为了快速上手,我们选用对新手比较友好的 Cherry Studio 来进行第一个 MCP 接入示例。它的优点在于可以一键安装所需的底层环境(如 Node.js 等),而许多其他工具(如 Windsurf)则需要用户手动安装。

- 安装环境:打开 Cherry Studio 客户端,在“设置” -> “MCP 服务器”中,根据提示安装所需的环境。

- 添加 Server:在搜索框搜索

@modelcontextprotocol/server-filesystem,这是一个简单的文件系统访问 Server。 - 配置 Server:点击“+”号添加,系统会自动填充部分配置。我们需要补充一个

args参数,指定允许访问的本地文件夹路径,例如~/Desktop(代表你的桌面)。 - 保存并启用:点击保存。如果服务器状态显示为绿灯,说明配置成功。

- 聊天测试:

- 回到聊天界面,选择一个带有扳手 图标的模型(这表示该模型支持工具调用,因为 Cherry Studio 的 MCP 实现底层依赖 Function Call)。

- 在下方的工具箱中,打开 MCP 开关。

- 尝试提问,让模型访问你指定的文件夹,例如:“列出我桌面上的所有文件”。

如果一切顺利,模型会调用 MCP Server 并返回文件列表。

注意:Cherry Studio 对 MCP 的支持尚处早期,实测中支持的模型有限且稳定性有待提高。因此,在接下来的实战环节,我们将切换到 VSCode + Cline 的组合。不过,工具本身的选择不必过于纠结,MCP 生态发展迅猛,未来会有更多更成熟的工具涌现。核心是掌握其使用思路。

四、实战:使用 MCP 调用数据库

接下来,我们将演示如何通过 MCP 让大模型查询数据库中的结构化数据。

4.1 准备数据库 (MongoDB)

我们选择 MongoDB 作为示例数据库,它是一款流行的开源文档型数据库。

- 为什么选择 MongoDB? 相比关系型数据库(如 SQLite)固定的表结构,MongoDB 的文档模型(基于 JSON 格式)更加灵活。你可以轻松地在同一个“集合”(相当于表)中存储不同结构的“文档”(相当于行),方便后续补充和修改字段,这对于构建持续演化的结构化知识库非常友好。

- 安装:

- 从官网下载并安装 MongoDB Community Server (https://www.mongodb.com/try/download/community)。安装后,它会默认监听本地的

27017端口。 - 下载并安装 MongoDB Compass (https://www.mongodb.com/try/download/compass),这是一个官方提供的 GUI 可视化管理工具。

- 从官网下载并安装 MongoDB Community Server (https://www.mongodb.com/try/download/community)。安装后,它会默认监听本地的

- 连接与导入数据:

- 打开 Compass,连接到本地运行的 MongoDB Server (通常连接字符串是

mongodb://localhost:27017/)。 - 导入你的数据。在本文示例中,我们假设有两份数据:学生信息 (students) 和 学生分数 (scores)。

- (此处展示导入后的数据结构截图或描述,例如:)

- students 集合: 包含学号(_id), 姓名(name), 性别(gender), 身高(profile.height), 班级ID(classId) 等字段。

- scores 集合: 包含学生ID(studentId), 课程ID(courseId), 平时成绩(usualScore), 期末成绩(finalScore) 等字段。

- (此处展示导入后的数据结构截图或描述,例如:)

- 提示: 如果不熟悉 MongoDB 数据导入,可以利用 AI (如 DeepSeek) 生成导入脚本。例如,提供表格数据并提问:“帮我编写一个 Node.js 脚本,将当前表格中的数据导入我本地 MongoDB 的

studentManagement数据库下的students集合中。” 然后根据 AI 生成的脚本执行导入。

- 打开 Compass,连接到本地运行的 MongoDB Server (通常连接字符串是

4.2 配置开发环境 (VSCode + Cline)

在对比了几个支持 MCP 的客户端后,Cline 是一个表现不错的选择:开源、免费、国内可直接使用,且对 MCP 的兼容性较好。但需要注意的是,Cline 本质上是 Visual Studio Code (VSCode) 的一个 AI 编码辅助插件,因此使用门槛相比 Cherry Studio 这类独立客户端稍高。

- 背景: 许多付费的 AI 编程工具(如 Cursor, Windsurf)实际上是基于微软开源的 VSCode 进行二次开发和包装,内置了 AI 功能。Cline 则直接作为 VSCode 插件提供,支持配置多种第三方 AI API,灵活性很高。对于 AI 编程新手,

VSCode + Cline是一个推荐的入门组合。 - 安装 Cline:

- 打开 VSCode。

- 在左侧扩展商店中搜索

Cline。 - 选择下载量最高的官方版本进行安装。

- 配置模型:

- 安装完成后,在 VSCode 左侧活动栏找到 Cline 图标,点击打开设置。

- 配置你使用的 AI 模型 API。Cline 支持多种模型提供商(如 OpenAI, Anthropic, Google Gemini, 以及国内的 MiniMax, Moonshot 等),按需选择并填入你的 API Key。

- 配置完成后,可以在 Cline 的聊天窗口进行测试,确保模型能正常响应。

4.3 在 Cline 中配置 mcp-mongo-server

现在,我们需要找到并配置一个用于 MongoDB 的 MCP Server。在官方 Server 仓库或 MCP.so 上搜索,可以发现已有多个选择。这里我们选用 mcp-mongo-server (https://github.com/kiliczsh/mcp-mongo-server)。

配置步骤:

- 打开 Cline 的 MCP 配置: 在 Cline 界面顶部找到 MCP Server 图标(可能是一个小方块或类似标识)。Cline 内置了一些常用 Server 并支持一键安装。由于

mcp-mongo-server不在内置列表中,我们需要手动配置。点击 "Installed" 或类似标签页,然后找到并点击 "Configure MCP Servers"(或类似按钮),这会打开一个名为mcp_servers.json(或类似名称) 的 JSON 配置文件,初始内容通常是一个空对象{}。 - 获取配置模板: 每个 MCP Server 的文档通常会提供其配置写法。对于

mcp-mongo-server,其文档提供了适用于 Claude Desktop 的配置,这些配置同样适用于 Cline 等支持 MCP 的客户端。 - 理解配置参数: 文档中可能提供多种配置选项,但核心参数通常是:

command: 指定启动 Server 的命令行命令。在此例中,使用npx(Node.js 包执行器)。args: 一个数组,包含传递给command的参数。- 示例配置解读:

mongodb: 运行mcp-mongo-servernpm 包,连接到指定的 MongoDB 地址,默认为读写模式。mongodb-readonly: 增加了--read-only参数,以只读模式运行。mongodb-github: 从 GitHub 仓库直接运行,而非 npm 包。

- 编写配置:

- 获取连接字符串: 在 MongoDB Compass 中,找到你的

studentManagement数据库的连接字符串。对于本地默认安装且无密码的 MongoDB,通常是mongodb://localhost:27017/studentManagement?authSource=admin。 - 配置 JSON: 将以下配置粘贴到 Cline 的 MCP 配置文件中:

- 获取连接字符串: 在 MongoDB Compass 中,找到你的

{

"mongodb": {

"command": "npx",

"args": [

"mcp-mongo-server",

"mongodb://localhost:27017/studentManagement?authSource=admin"

]

}

}

- 验证配置: 保存 JSON 文件。回到 Cline 的 MCP Server 管理界面,你应该能看到名为

mongodb的 Server,并且其状态灯变为绿色,表示连接成功。 - 确保环境: 使用

npx命令的前提是你的电脑已安装 Node.js 环境。可以在 Node.js 官网 (https://nodejs.org/) 下载安装包一键安装。安装后,在命令行运行npx -v检查是否安装成功。

测试 MCP 查询:

有个学计算机的周同学,他老师的联系方式给我一下,在这个查询中,模型先找到了所有姓周的同学,然后根据这些通过的班级过滤除了计算机相关班级,最后根据班级关联的 teacherId 找到了教师信息。

4.4 通过 Prompt 优化查询效果

虽然 MCP Server 提供了数据库访问能力,但数据库的表结构对大模型来说仍是“黑箱”。模型需要猜测或先查询元数据才能构建有效查询,这可能导致出错、响应变慢和消耗更多 Token。

优化技巧:在系统提示词 (System Prompt) 或 Cline 的 Custom Instructions 中,明确告知模型数据库的表结构和关键信息。

- 生成表结构描述: 可以让 AI (如 DeepSeek) 帮你生成详细的表结构说明文档。例如,提供你的数据库模式,然后要求:“使用中文回复。请为我的学生管理系统 MongoDB 数据库生成详细的表结构说明文档,包含 teachers, classes, courses, students, scores 这几个集合,以及它们的字段名、类型、描述、约束和示例。” (参考原稿中提供的详细表结构 Prompt)

- 配置到 Cline:

- 复制生成的表结构描述。

- 在 Cline 的设置中找到 "Custom Instructions" 或类似选项。

- 将描述粘贴进去,并保存 (点击 "Done")。

使用中文回复。

当用户提问中涉及学生、教师、成绩、班级、课程等实体时,需要使用 MongoDB MCP 进行数据查询和操作,表结构说明如下:

# 学生管理系统数据库表结构说明

## 1. 教师表 (teachers)

| 字段名 | 类型 | 描述 | 约束 | 示例 |

|--------|------|------|------|------|

| _id | String | 教师ID | 主键 | "T001" |

| name | String | 教师姓名 | 必填 | "张建国" |

| gender | String | 性别 | "男"或"女" | "男" |

| subject | String | 教授科目 | 必填 | "数学" |

| title | String | 职称 | 必填 | "教授" |

| contact.phone | String | 联系电话 | 必填 | "13812345678" |

| contact.office | String | 办公室位置 | 必填 | "博学楼301" |

| contact.wechat | String | 微信(可选) | 可选 | "lily_teacher" |

| isHeadTeacher | Boolean | 是否为班主任 | 可选 | true |

## 2. 班级表 (classes)

| 字段名 | 类型 | 描述 | 约束 | 示例 |

|--------|------|------|------|------|

| _id | String | 班级ID | 主键 | "202301" |

| className | String | 班级名称 | 必填 | "2023级计算机1班" |

| grade | Number | 年级 | 必填 | 2023 |

| headTeacherId | String | 班主任ID | 外键(teachers._id) | "T003" |

| classroom | String | 教室位置 | 必填 | "1号楼302" |

| studentCount | Number | 学生人数 | 必填 | 35 |

| remark | String | 备注信息 | 可选 | "市级优秀班集体" |

## 3. 课程表 (courses)

| 字段名 | 类型 | 描述 | 约束 | 示例 |

|--------|------|------|------|------|

| _id | String | 课程ID | 主键 | "C001" |

| courseName | String | 课程名称 | 必填 | "高等数学" |

| credit | Number | 学分 | 必填 | 4 |

| teacherId | String | 授课教师ID | 外键(teachers._id) | "T001" |

| semester | String | 学期 | 格式"YYYY-N" | "2023-1" |

| type | String | 课程类型 | "必修"或"选修" | "必修" |

| prerequisite | String | 先修课程ID | 可选,外键(courses._id) | "C003" |

## 4. 学生表 (students)

| 字段名 | 类型 | 描述 | 约束 | 示例 |

|--------|------|------|------|------|

| _id | String | 学号 | 主键 | "S20230101" |

| name | String | 学生姓名 | 必填 | "王强" |

| gender | String | 性别 | "男"或"女" | "男" |

| birthDate | Date | 出生日期 | 必填 | new Date("2005-01-15") |

| enrollmentDate | Date | 入学日期 | 必填 | new Date(2023, 8, 1) |

| classId | String | 班级ID | 外键(classes._id) | "202301" |

| contact.phone | String | 联系电话 | 必填 | "13812345678" |

| contact.email | String | 电子邮箱 | 必填 | "20230101@school.edu.cn" |

| contact.emergencyContact | String | 紧急联系人电话 | 必填 | "13876543210" |

| address | String | 家庭住址 | 必填 | "北京市海淀区中关村大街1栋101室" |

| profile.height | Number | 身高(cm) | 必填 | 175 |

| profile.weight | Number | 体重(kg) | 必填 | 65 |

| profile.healthStatus | String | 健康状况 | 必填 | "良好" |

## 5. 成绩表 (scores)

| 字段名 | 类型 | 描述 | 约束 | 示例 |

|--------|------|------|------|------|

| _id | String | 成绩记录ID | 主键 | "S20230101C001" |

| studentId | String | 学生ID | 外键(students._id) | "S20230101" |

| courseId | String | 课程ID | 外键(courses._id) | "C001" |

| score | Number | 综合成绩 | 0-100 | 85 |

| examDate | Date | 考试日期 | 必填 | new Date(2024, 5, 20) |

| usualScore | Number | 平时成绩 | 70-100 | 90 |

| finalScore | Number | 期末成绩 | 0-100 | 80 |

### 补考成绩记录说明

补考记录在_id后添加"_M"后缀,如"S20230101C001_M"

## 表关系说明

1. **一对多关系**:

- 一个班级(classes)对应多个学生(students)

- 一个教师(teachers)可以教授多门课程(courses)

- 一个学生(students)有多条成绩记录(scores)

2. **外键约束**:

- students.classId → classes._id

- courses.teacherId → teachers._id

- scores.studentId → students._id

- scores.courseId → courses._id

- classes.headTeacherId → teachers._id

4.5 对比 RAG 知识库

为了直观感受效果差异,我们将同样的数据集导入基于 RAG 的知识库进行对比。

- 简单表查询 (单表信息): 使用 Coze 的知识库功能导入学生信息表。对于简单的单表查询(如“王强同学的基本信息”),RAG 可能表现尚可。

- 复杂查询 (多条件、跨表): 尝试之前在 MCP 中测试成功的复杂问题,例如“身高 180-190cm 的女生有哪些?” 或 “哪些同学期末考试比平时成绩好?”

- 结果:在 Coze 的 RAG 知识库中,对于这类需要精确匹配和逻辑推理的结构化数据查询,模型往往难以给出准确答案,结果可能含糊不清或完全错误。

结论:对比非常明显。在处理结构化数据的检索场景下,MCP + 数据库 的方式在精度和能力上显著优于传统的 RAG 方法。

4.6 目前的局限性

尽管前景看好,但目前基于 MCP + 数据库的方案仍存在一些局限性:

- 大数据量查询的成本和性能:与 RAG 每次只检索相关文本片段不同,MCP + 数据库的方式会实际执行数据库查询 (类似 SQL)。如果查询返回的数据量非常大,可能会导致:

- 高昂的 Token 消耗:大量数据需要传递给大模型进行处理和总结。

- 性能问题:可能导致 MCP 客户端响应缓慢甚至卡死。因此,应避免让 AI 一次性检索过大的数据集。

- Token 消耗增加:许多 MCP 客户端(包括 Cline)为了实现模型与 Server 的通信,依赖于复杂的系统提示词 (System Prompt)。这意味着一旦启用 MCP,即使是简单的交互,Token 的消耗量也可能比普通聊天大幅增加。

五、总结与展望

在此之前,基于 Function Call + Text2SQL 的方案也有尝试,但因开发成本高、准确性难以保证等问题未能普及。

而我们今天学习的 MCP + 数据库 模式,真正意义上降低了结构化数据接入 AI 的门槛(甚至可以零代码实现),并且查询准确性非常高。

尽管目前还存在一些局限性(如大查询成本、Token 消耗),但其潜力巨大。我们有理由相信,未来这种模式将在智能客服、仓储管理、信息管理系统等重度依赖结构化数据检索的场景中,成为一种非常热门甚至主流的查询方式,很可能会在这些特定领域替代传统 RAG 的地位。

MCP 生态正在快速发展,未来可期!

如何系统的去学习大模型LLM ?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

事实上,抢你饭碗的不是AI,而是会利用AI的人。

继科大讯飞、阿里、华为等巨头公司发布AI产品后,很多中小企业也陆续进场!超高年薪,挖掘AI大模型人才! 如今大厂老板们,也更倾向于会AI的人,普通程序员,还有应对的机会吗?

与其焦虑……

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高。

基于此,我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近70次后,终于把整个AI大模型的学习门槛,降到了最低!

在这个版本当中:

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包,现在将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、LLM大模型经典书籍

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套LLM大模型报告合集

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、LLM大模型系列视频教程

四、LLM大模型开源教程(LLaLA/Meta/chatglm/chatgpt)

五、AI产品经理大模型教程

LLM大模型学习路线 ↓

阶段1:AI大模型时代的基础理解

-

目标:了解AI大模型的基本概念、发展历程和核心原理。

-

内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践

- L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

-

目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

-

内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例

- L2.2 Prompt框架

- L2.3 流水线工程

- L2.4 总结与展望

阶段3:AI大模型应用架构实践

-

目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

-

内容:

- L3.1 Agent模型框架

- L3.2 MetaGPT

- L3.3 ChatGLM

- L3.4 LLAMA

- L3.5 其他大模型介绍

阶段4:AI大模型私有化部署

-

目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

-

内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

这份 LLM大模型资料 包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

更多推荐

已为社区贡献84条内容

已为社区贡献84条内容

所有评论(0)