如何在 Hugging Face Hub 上使用 Ollama 和 GGUF 模型

Ollama 默认使用Q4_K_M量化方案,如果你希望使用不同的量化方案,只需从模型页面的“文件和版本”选项卡中选择你想要的 GGUF 文件,然后在“使用此模型”下拉菜单中选择 Ollama。如果你想自定义聊天模板,可以在你的存储库中创建一个名为template的新文件。此外,你还可以通过创建名为 system 的新文件来配置系统提示,或者通过创建名为 params 的文件来更改采样参数。确保这个

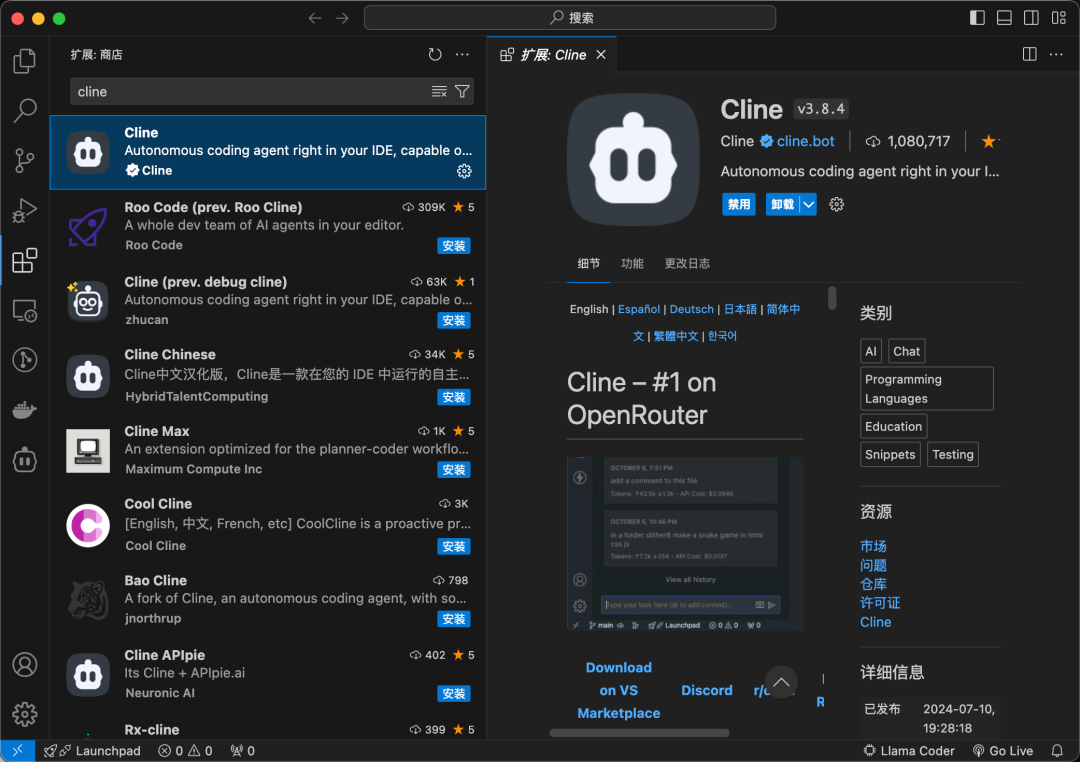

大家好,今天我们要讨论的是如何在 Hugging Face Hub 上利用 Ollama 应用程序与 GGUF 模型进行交互。这是一个非常强大的工具,可以让你直接在本地计算机上使用大型语言模型,接下来我将逐步带你了解。

首先,什么是 Ollama 呢?Ollama 是一个基于 llama.cpp 的应用程序,它让用户能够轻松地与 LLMs 互动。你可以直接使用 Hugging Face 上社区创建的任何 GGUF 模型,而无需编写新的 Modelfile。这意味着,你可以利用现有的 45,000 个公共 GGUF 检查点,只需输入一条命令,就能快速运行它们。

如何入门

入门非常简单!首先,你需要在本地应用程序设置中启用 Ollama。接下来,在你想使用的模型页面上,从“使用此模型”下拉菜单中选择 Ollama,比如 bartowski/Llama-3.2-1B-Instruct-GGUF。接下来,使用以下格式的命令运行模型:

ollama run hf.co/{username}/{repository}注意,你可以使用 hf.co 或 huggingface.co作为域名,这样就更加灵活了。

尝试一些模型

这里有几个推荐的模型,你可以立即尝试:

ollama run hf.co/bartowski/Llama-3.2-1B-Instruct-GGUF

ollama run hf.co/mlabonne/Meta-Llama-3.1-8B-Instruct-abliterated-GGUF

ollama run hf.co/arcee-ai/SuperNova-Medius-GGUF

ollama run hf.co/bartowski/Humanish-LLama3-8B-Instruct-GGUF自定义量化

Ollama 默认使用 Q4_K_M 量化方案,如果你希望使用不同的量化方案,只需从模型页面的“文件和版本”选项卡中选择你想要的 GGUF 文件,然后在“使用此模型”下拉菜单中选择 Ollama。命令格式如下:

ollama run hf.co/{username}/{repository}:{quantization}例如:

ollama run hf.co/bartowski/Llama-3.2-3B-Instruct-GGUF:IQ3_M自定义聊天模板和参数

如果你想自定义聊天模板,可以在你的存储库中创建一个名为 template 的新文件。这个模板必须是 Go 模板,下面是一个示例:

{

{ if.System}}<|system|>

{

{.System}}<|end|>

{

{end}}{

{if.Prompt}}<|user|>

{

{.Prompt}}<|end|>

{

{end}}<|assistant|>

{

{.Response}}<|end|>此外,你还可以通过创建名为 system 的新文件来配置系统提示,或者通过创建名为 params 的文件来更改采样参数。确保这个文件是 JSON 格式的,具体的参数列表可以参考相关文档。

总结

总的来说,Ollama 为我们提供了一个非常便捷的方式去利用 Hugging Face Hub 上的 GGUF 模型,无论是研究、开发还是日常使用,都是一个不可多得的工具。如果你对这项技术感兴趣,不妨试试看!感谢大家的收看,我们下次再见!

博主会不定期的分享各种有关深度学习、机器学习、AI大模型等AI方面的内容。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)